ドイツ:マックス・プランク情報科学研究所、ザールラント大学、スタンフォード大学、レイ・フアン・カルロス大学の研究者らは、単一RGBカメラでキャプチャした動画からCNN(Convolutional neural network)を用いて手指の追跡をするリアルタイム3Dハンドトラッキング技術を発表しました。

論文:GANerated Hands for Real-Time 3D Hand Tracking from Monocular RGB

著者:Franziska Mueller、Florian Bernard、Oleksandr Sotnychenko、Dushyant Mehta、Srinath Sridhar、Dan Casas、Christian Theobalt

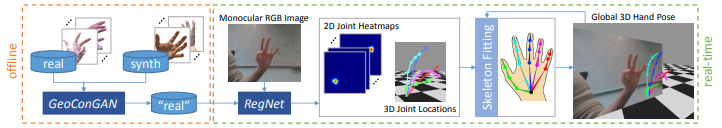

本稿は、単一のRGBカメラで撮影されたビデオストリームを入力に、ネットワークに基づいてリアルタイムの3Dハンドトラッキングを提案します。上画像のように、指が物で隠れたとしても乱れることなく正確に推定することができます。

提案手法では、入力された画像から手関節の2D/3D位置を予測するためにCNN RegNetが用いられます。2D位置はヒートマップとして、3D位置は座標として、両者のデータを融合し精度を高めます。

トレーニングデータには、敵対生成学習のGeoConGANを用いて生成した手の画像を使用します。合成画像を実画像に変換するネットワークとしてGANが用いられます。

これらのことで、オブジェクトに隠れたとしても推定し、手の動きを正確にトラッキングすることを可能にします。ただし、背景が手のような外観や、複数の手が入力画像内で重なったりしていると、追跡が不安定になるとしています。

関連

元Microsoft Researchら、最大1000fpsで動作する深度カメラベースのハンドトラッキングを論文にて発表。様々なジェスチャ入力も披露 | Seamless