慶應義塾大学と南オーストラリア大学の研究者らは、光センサと機械学習を用いて耳を入力インタフェースにするイヤフォン型デバイス「EarTouch」を論文にて発表しました。

EarTouch: 耳の入力インタフェース化

著者:菊地 高史、正井 克俊、杉本 麻樹、Bruce H. Thomas、杉浦 裕太

本稿は、従来のイヤフォンサイズを維持したデバイスを用いて、耳を多様な方向に引っ張ると入力できる手法を提案します。コードレス化が進んでいるイヤフォンに対する有効な入力手法として期待できます。

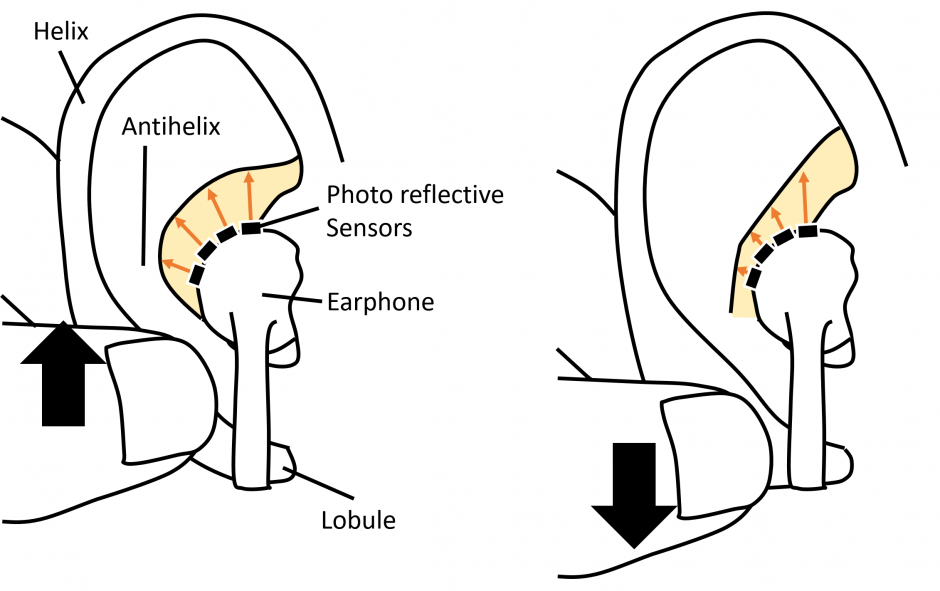

提案手法は、イヤフォンに装着した4つの反射型光センサを用いて耳の変形(耳を引っ張ることで変化するイヤフォンから耳の皮膚までの距離)を取得し、取得したセンサデータを基に教師あり機械学習「SVM(Support Vector Machine)」でジェスチャを識別します。

学習後は、耳を軽くつかんだ状態を含め上下左右の5種類の方向ジェスチャを認識します。また、方向ジェスチャを用いて記号ジェスチャの「直線」「v字」「不等号記号」「四角」「階段」といった、より複雑な入力も可能にします。

関連

Media Interaction LabやGoogleら、腕に着用するアームスリーブ型の衣服センサ「SmartSleeve」を発表。多様なジェスチャをリアルタイムに感知 | Seamless