米デューク大学は、ロボットがカメラやセンサーで複数の角度から調べることなく、新しいオブジェクトの見えない部分も推測し解釈することができるアルゴリズムを開発しました。

ロボットがカメラや他のセンサーを使って物体を「見る」ことは比較的簡単ですが、解釈することは困難です。

人間の場合、新しい物体を一目見ただけでそれが正面か逆さまであるか、他の物体によって部分的に覆われているのか、見えない部分はどんな感じなのか、など直感的に認識することができ何であるかを解釈することができます。

本アルゴリズムは、そんな人間的に物を見るアプローチを採用しており、複数の角度から調べることなく、どの向きなのか、見えない部分はどうなっているのか、などを推測し新しい物体が何であるかを解釈します。

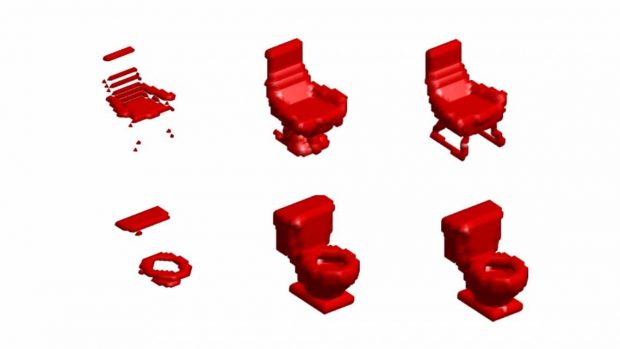

上の図は、左がロボットに与えた情報、真中がその情報から推測した3Dモデル、右が正解の3Dモデルです。補って的を外すことなく解釈しているのが確認できます。

本アルゴリズムは、家庭や他の現実の環境で人間と一緒に機能するロボットにとって重要なステップだと、開発者はそう述べています。

関連

UCバークレー、これまでに見たことがない物体を機械学習によって最良の掴み方を選択し実行するロボティクス・システム「Dex-Net」を発表 | Seamless