CSAIL MITとIBM Researchの研究者たちは、AIシステムが動画を認識し理解するのに役立つ動画ベースの大規模なデータセット「Moments in Time Dataset」を公開しました。

論文も発表しました。

Moments in Time Dataset: one million videos for event understanding(PDF)

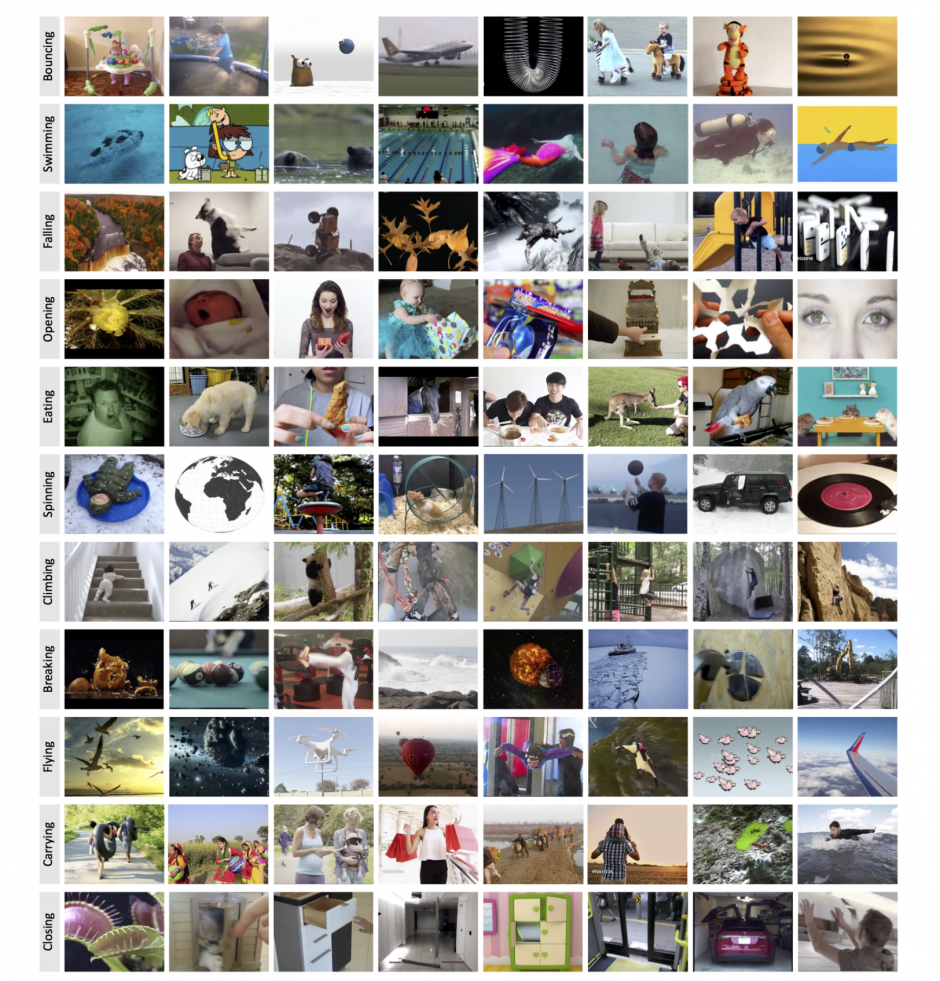

本稿では、映像内のアクションやイベントにラベル付けされた3秒以内の動画が100万点あるデータセットを紹介します。例えば、以下の図を確認します。左に動画内の出来事が書かれたテキストが表示され、横一列にその出来事の3秒動画シーンが羅列します。

「Flying」であれば、ドローンが飛ぶ映像、スカイダイビングの映像、気球が飛ぶ映像、鳥が飛ぶアニメーション映像、など。「Climing」であれば、赤ちゃんが階段を登る映像、パンダが木に登る映像、ロッククライミングをする映像、子供がジャングルジムを登る映像、など。

そういった映像内で何が起きているのかに焦点を当てた事象をベースにしてラベル付けされたデータセットになります。抽象度が高いラベルに対応しているデータセットとも言えます。

3秒動画の検索はこちらから。

(ビデオ内のイベントを認識するためにニューラルネットワークが注目しているフレームの領域を示しています。「CAM:Class Activation Mapping」が用いられています。)

関連

NVIDIA、教師なし学習と生成モデルを組み合わせて画像から画像へ変換する手法を論文発表。晴れを雨のシーンに、冬を夏のシーンに変換など | Seamless