Facebook AI Researchは、機械学習を用いてユーザーの顔の表情を読み取り「インタラクティブ・エージェント」に役立てる手法「Learn2Smile」を公開しました。

Learn2Smile: Learning Non-Verbal Interaction Through Observation

昨今、テキストチャットや音声でエージェントと対話しながら必要な情報にたどり着く「インタラクティブ・エージェント」という手法が用いられるケースが増えてきています。

背景には、自然言語認識や音声認識の進化が大きく影響していますが、一方でユーザーの表情を認識し反応する分野がおろそかになっています。

そこで、本論文では、ユーザーの表情(非言語)に基づいてエージェントを自動更新する機械学習を用いた手法を提案します。

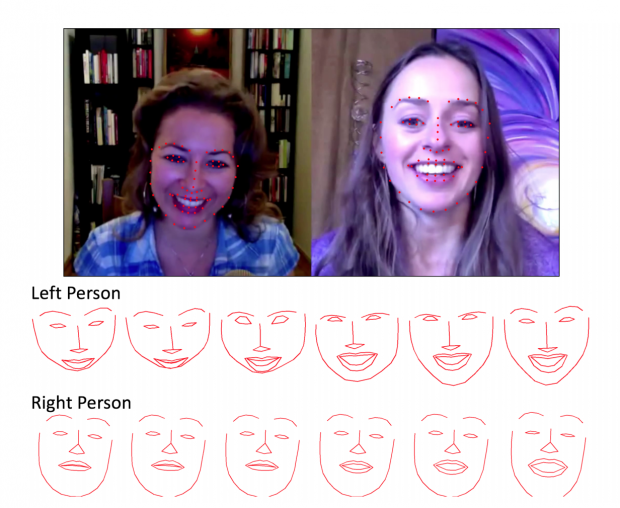

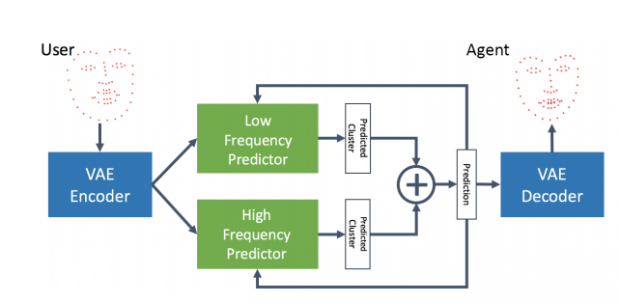

機械学習には、Deep neural network(DNN)が用いられ、数百のビデオを使用して訓練します。モデルは、VAE(Variational Autoencoder)を利用し、ユーザーの顔からのトラッキング2Dポイントデータを基にエンコードします。

そのことで、ユーザーとエージェントが言語と非言語(表情)の組み合わせで対話することが可能となり、インタラクティブ・エージェントとしてより進化するとしています。

関連

Google、自然言語で対話できるAI「Google Assistant」のSDKをリリース。Google Assistant搭載デバイスが開発可能へ | Seamless