慶應義塾大学、東京大学、東京工業大学の研究者らは、追跡したユーザの視線を3Dオブジェクト上に可視化する3D視線マッピングシステムを発表しました。

論文:Object-wise 3D Gaze Mapping in Physical Workspace

著者:Kakeru Hagihara、Keiichiro Taniguchi、Irshad Abibouraguimane、Yuta Itoh、Keita Higuchi、Jiu Otsuka、Maki Sugimoto、Yoichi Sato

本稿は、3Dオブジェクト上にユーザの注視軌跡を投影する可視化システムを提案します。3D空間においてユーザが各オブジェクトをどれだけ眺めているかを測定することができます。

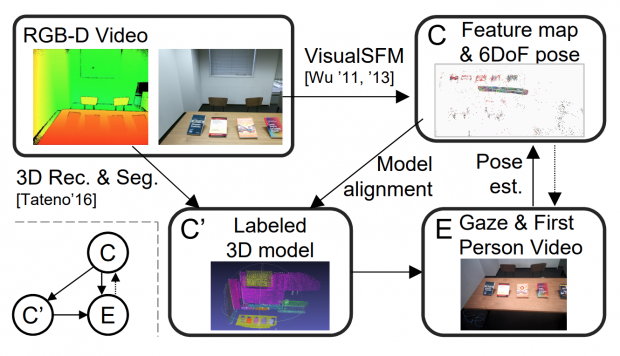

提案手法は、ワークスペースを再構築する準備段階と、ユーザの視線を追跡する視覚化段階から構成されています。準備段階では、Microsoft Kinect V2がワークスペースの画像を記録し、オブジェクトごとにセグメーション化、3D空間でラベル付きメッシュモデルとマップを生成します。

視覚化段階では、視線追跡デバイスにTobii Pro Glass 2を用いて、一人称視点とそれに対応する注視点をキャプチャします。

提案手法の特徴として、自動的にアノテーションする機能が整備されているところが挙げられます。そのため、アノテーションされた各オブジェクトの視線統計を抽出することができ、これにより、各オブジェクトの視線分布を解析し、3D空間におけるユーザの意図を解釈することが可能になります。

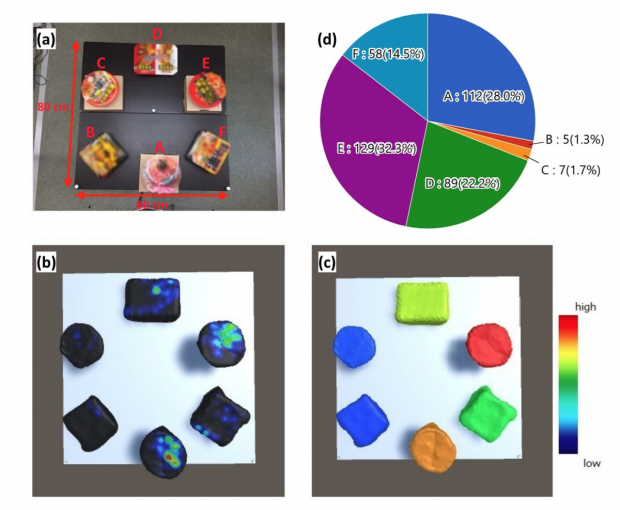

例えば、論文内の実験では、下図のように、どのカップ麺をどれだけ注視したかを分析するため、円グラフやヒートマップ、オブジェクトを色分けするなどのランキング形式で可視化することができます。

このことで、ユーザがどの商品に興味があり、どれと迷っているかなどの情報を得ることが可能になります。

将来的なアプローチとして、提案されたシステムはカメラポーズを推定するのに時間を費やしているため、自己位置推定と環境マップ作成を同時に行う「SLAM(Simultaneous Localization and Mapping)」を利用することで、カメラポーズをリアルタイムで推定することを計画しています。

関連

ケンブリッジ大学ら、動画内の人の視線方向を後から変更することができる技術「GazeDirector」発表 | Seamless