慶應義塾大学杉本研究室と東京大学稲見・檜山研究室による研究チームは、顔の表情をロボットアームの制御に使用するシステム「FaceDrive」を発表しました。

論文:FaceDrive: Facial Expressions Commands to Control Virtual Supernumerary Robotic Arms

Masaaki Fukuoka ¹ Adrien Verhulst ² Fumihiko Nakamura ¹ Ryo Takizawa ¹ Katsutoshi Masai ¹ Maki Sugimoto ¹

¹ Keio University, Japan ² The University of Tokyo, Japan

本研究は、 顔の表情(Facial Expressions,FE)からロボットアーム (Supernumerary Robotic Limbs ,SRLs) を制御するシステムを提案します。開発には、費用対効果が高く安全で高速なプロトタイピングが行えるVR(バーチャルリアリティ)環境を用いることで提案手法による制御が可能であることを検証しています。

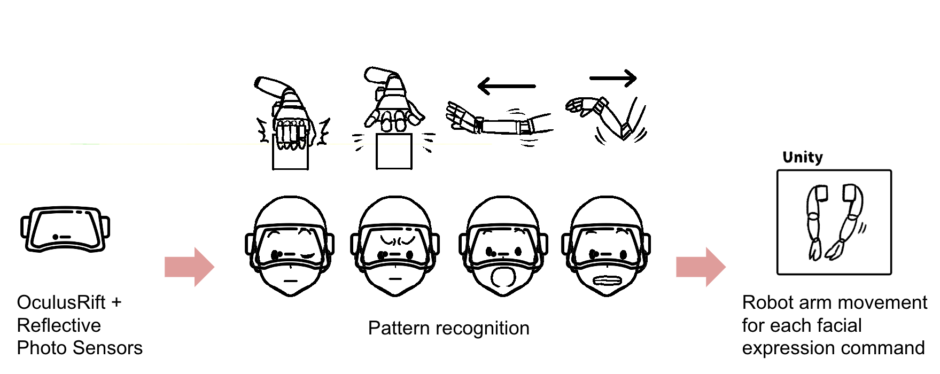

オペレーターは、VR HMD(ヘッドマウントディスプレイ)を装着します。装着するVR HMDの内側には、16個の反射型フォトセンサーが組み込まれており顔の表情を識別することができます。 開発したシステムでは、4つのコマンド(アームを伸ばす、縮める、掴む、離す)に対応した任意の表情を機械学習することでロボットアームの操作を可能としています。

ロボットアームは、伸縮コマンドとオペレーターの頭部方向に応じて,左右両腕アームのうち頭部方向へ近接している一方のアームがリーチングする仕組みになっています。制御にはオペレーターの多様な表情を使用できますが、一例としては、口を開ける動作にアームを伸ばす、口をニッとする動作にアームを縮めるといったコマンドを割り当てることや、片目を閉じる動作に掴む、眉をひそめる動作に離すといったコマンドを割り当てることができます。

これにより、自分の手とは別に、ロボットアームを顔の表情で制御し、目の前に配置された物体を掴んで、移動させるといったことが可能になります。次のステップとしては、人が自然にする驚きなどの無意識下での表情で制御するシステムを目指します。

この研究は、科学技術振興機構 戦略的創造研究推進事業ERATO稲見自在化身体プロジェクトの研究成果です。