Facebook Reality Labsによる研究チームは、VRプレイヤーの顔の動きをリアルタイムに再構築するシステムを発表しました。

論文:VR Facial Animation via Multiview Image Translation

SHIH-EN WEI, JASON SARAGIH, TOMAS SIMON, ADAM W. HARLEY∗, STEPHEN LOMBARDI,MICHAL PERDOCH, ALEXANDER HYPES, DAWEI WANG, HERNAN BADINO, and YASER SHEIKH

Facebook Reality Labs

∗Currently at Carnegie Mellon University, work done while at Facebook Reality Labs.

ソーシャルVRにおいて、リアルアバターを使用することは一部で求められています。そこで本研究は、その一助としてヘッドセットマウントカメラ(Headset mounted cameras , HMC)を用いたVRリアルタイム顔面アニメーションシステムを提案します。

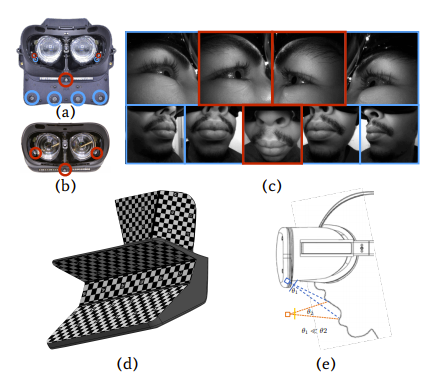

本提案は、VRプレイヤーから顔の動きをリアルタイムに再現するためエンドツーエンドの学習を行います。訓練用に、HMD内側に装備した9個(目周辺用に4個、口周辺用に5個)のカメラにより目や口を含む顔全体の表情をキャプチャします。また、訓練用とは別に、使用時に用いるヘッドセットマウントカメラは3個と最小限に留めた構成のHMDを使用します。

本研究は、ヘッドセットマウントカメラを用いて、双方間の顔アニメーションをリアルタイムに送信し合うVR向けシステムを実証しました。精度も高く、カメラも最小限に抑えた効率的なシステムを実現します。動画では、リアルアバターで動作している顔を確認できます。