Google BrainとDeepMindによる研究チームは、複数の映像内のイベントを時間的に整列させる機械学習を用いたフレームワークを「Temporal Cycle Consistency (TCC)」を発表しました。

論文:Temporal Cycle-Consistency Learning

著者:Debidatta Dwibedi, Yusuf Aytar, Jonathan Tompson, Pierre Sermanet , and Andrew Zisserman

所属:Google Brain and Deepmind

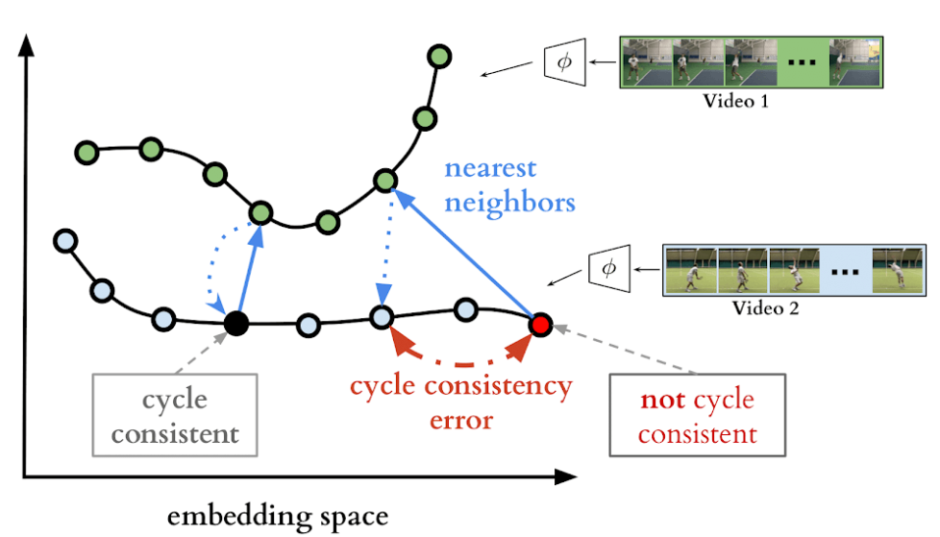

本論文は、複数のビデオにまたがって対応関係を見つけ整列させる学習法を提案します。本提案は、類似したビデオシーケンスを時間的に整列させることができる埋め込み(Embedding)空間を訓練するアプローチを採用します。まずエンコーダネットワークを使用してペアのビデオシーケンスを埋め込み空間に投影します。

上図の各点は対応するビデオのフレームを表します。Video 1の選択された点に対して、Video 2のnearest neighbor(NN)を見つけ、次にVideo 1の中でもnearest neighborを見つけます。このことで、選択したポイントが、同じポイントに戻ったときに一致(cycle consistency)したと判断します。(上図の黒点のケース)選択したポイントに戻らない場合は一貫性(not cycle consistency)がないと判断します。(上図の赤点のケース)

シーケンスのすべてのペアの点について、cycle consistency errorを最小限に抑え、埋め込み空間内のnearest neighborを使用した1対1マッピングができるフレーム数を最大化しようとします。これにより学習したモデルは、ビデオ内での埋め込み空間内でcycle-consistencyフレームを見つけるだけで、複数のビデオを整列させることができます。

例えば、野球のピッチャーが球を投げる複数の映像を整列させるとします。各ピッチャーのフォームスピードはそれぞれ違いますので、セットして投げるまでの時間はバラバラです。本モデルを使用すると、全員の投げるまでの時間が整列され、同じタイミングで投げるといったビデオに再構築されます。また、音を整列させることもできます。例えば、コップAに水を注いだ音をコップBに挿入する場合、コップBに注ぐ時間でAの音が組み込まれる結果を出力します。

また、本提案はビデオの位置合わせに触発されていますが、学習した表現は一般的であり、多数の細かいビデオ理解作業に役立ちます。