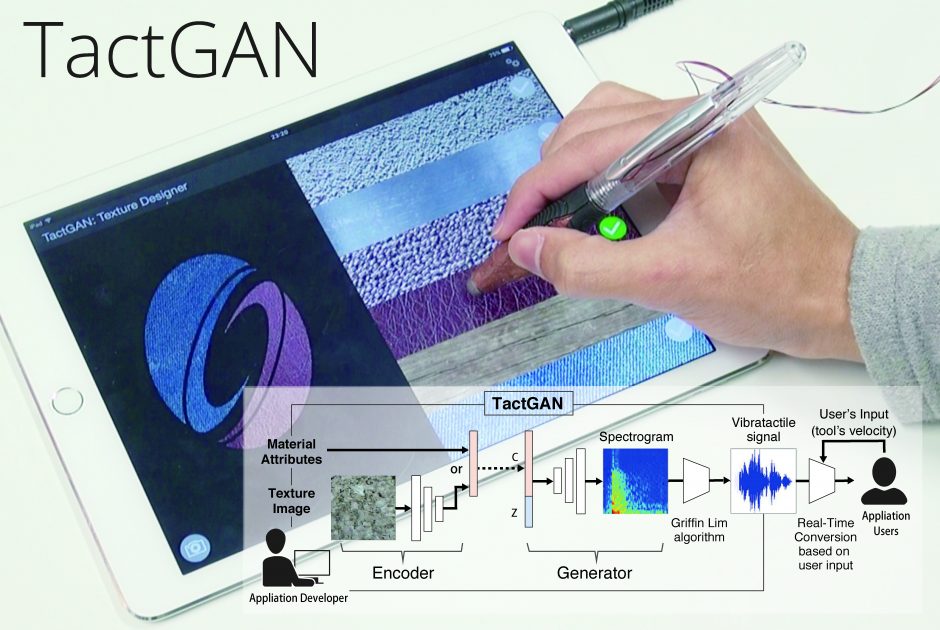

東京大学と日立製作所の研究チームは、表面の画像や属性から振動を生成するGAN(Generative Adversarial Network)を用いたデザイン手法「TactGAN」を発表しました。

論文:TactGAN: vibrotactile designing driven by GAN-based automatic generation

著者:Yuki Ban, Yusuke Ujitoko

所属:The University of Tokyo, Hitachi, Ltd.

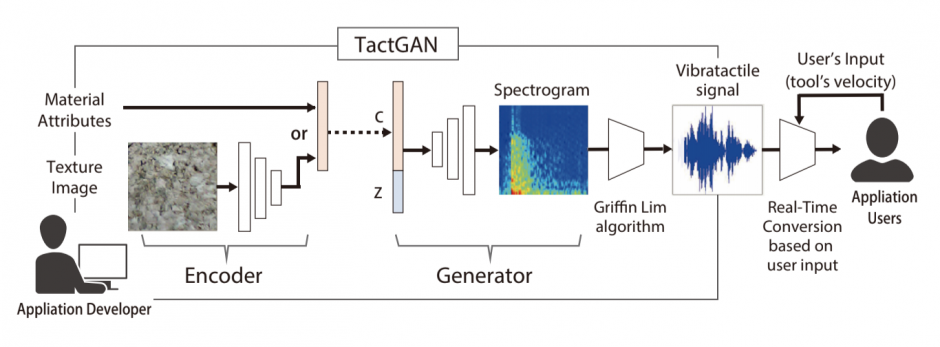

本論文は、素材の表面画像や表面属性の入力から、それらに適合した振動による触覚を生成する触覚フィードバック設計システムを提案します。本システムは、素材表面の画像や属性から、入力に応じた振動を自動生成するモデルです。

本提案手法は、EncoderとGeneratorの2つの別々に訓練されたニューラルネットワークから構成されています。Encoderは、ResNetベースのアーキテクチャを有しており、画像から触覚属性を抽出するために機能します。Generatorは、ResNet(Residual Network)とpixelCNNの複合アーキテクチャを有しており、触覚属性からシグナルを生成します。最後に、ユーザが接触するタップ強度やタブレット上を移動する速度などに基づいて、振動表面をリアルタイムに変換し触覚を再現します。

特筆したいのは、予め登録されていない素材の属性を入力しても、うまく合成してそれっぽい振動を返してくれるところです。

論文内では、10人の参加者に対して、タブレット上でペン型の触覚装置を動かすことによって生成する触覚フィードバックを提示し実験します。結果、参加者は、生成されたシグナルと本物のシグナルを区別できないくらいリアリティを感じたと報告しました。

これにより、ユーザは素材や触覚の属性パラメータを入力することで触覚を生成したり、画像を入力することで触覚を生成したりができ、質感デザインに不慣れな初心者でも効率的にデザインすることを可能にします。