北京航空航天大学と清華大学、MPI-Infによる研究チームは、1台の深度カメラを用いて着衣含めた人の動きを3D再構築するライブパフォーマンスキャプチャ「SimulCap」を発表しました。

論文:SimulCap : Single-View Human Performance Capture with Cloth Simulation

著者:Tao Yu, Zerong Zheng, Yuan Zhong, Jianhui Zhao, Qionghai Dai, Gerard Pons-Moll, Yebin Liu

所属:Beihang University, Tsinghua University, Max-Planck-Institute for Informatics

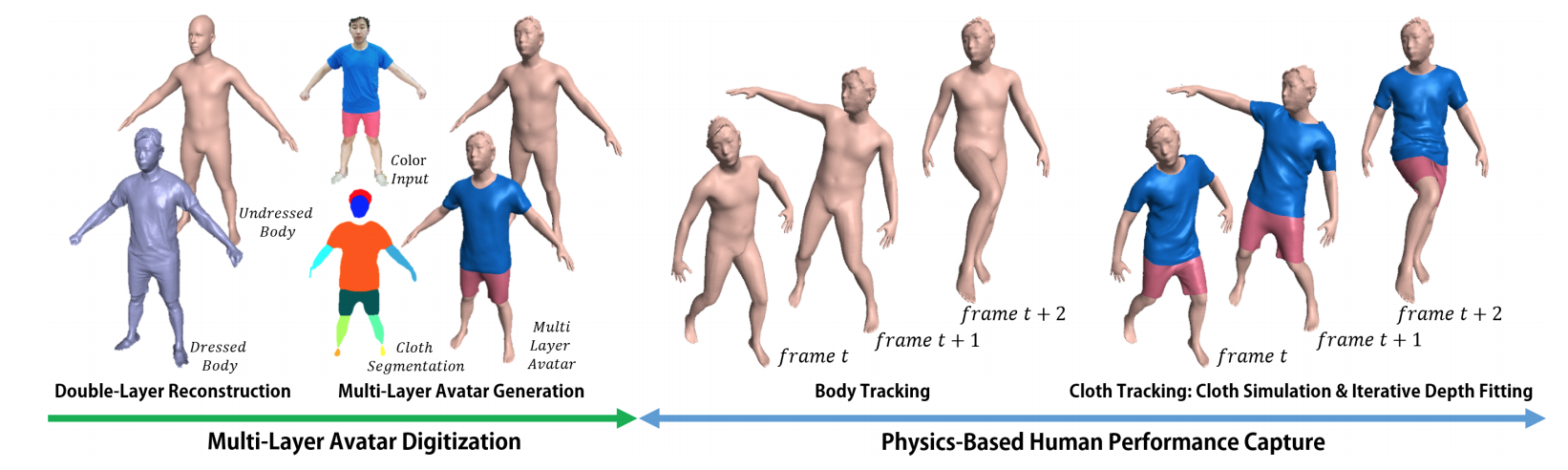

本論文は、単一のRGBDカメラを使用して、着ている衣服の動きを含めた人の動作を3D再構築するリアルタイム・パフォーマンスキャプチャを提案します。本提案は、1台のRGBDカメラから、物理的制約を取り入れながら人体の動き(パフォーマンスキャプチャ)と衣服の動き(物理ベースのシミュレーション)を別々に追跡し組み合わせることで再構築(隠れた部分含む)するライブキャプチャ法です。

具体的には、まずDoubleFusionを使用して服を着た体と服を着ていない体の表面を同時に捉える「Double-Layer Surface Reconstruction」と、服を着ていない体の動きと布の動的な深度データを追跡する「MultiLayer Avatar Generation」を使用して多層アバターを生成します。

衣服の変形は、その下の身体骨格の動きを捉えることで追跡することができ、そこへ衣服本体の動く深度を合わせることで、物理的制約を維持しながら動きにあった布シミュレーションを生成します。さらに、このことでカメラには映らない隠れた布部分の動きもシミュレートします。布シミュレーションには、Force-Based Mass-Springの拡張法が用いられます。

これらのことにより、1台の深度カメラから、着衣する衣服の動きを含めた人の動きを再現することができ、また見えない隠れた部分も同時にシミュレートするリアルアバターを構築することを可能にします。