カーネギー・メロン大学とFacebook Reality Labの研究者らは、別のビデオスタイルに動画を自動的に変換するGAN(Generative Adversarial Network)を用いたビデオリターゲット技術「Recycle-GAN」を発表しました。

論文:Recycle-GAN: Unsupervised Video Retargeting

著者:Aayush Bansal, Shugao Ma, Deva Ramanan, Yaser Sheikh

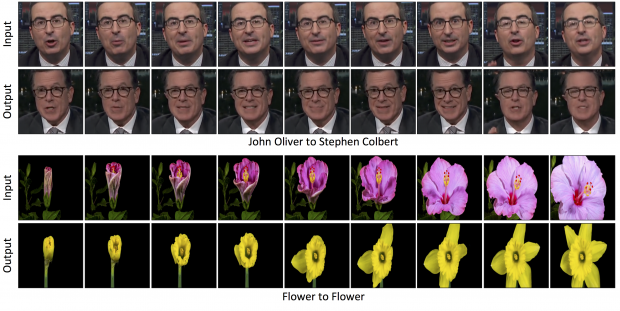

上段:上の顔の表情と動きを下の顔へ変換している。下段:紫色の花の開花を黄色の花へ変換している。

本論文は、一方のビデオスタイルを別のビデオへ変換し再構築する教師なしのデータ駆動型アプローチを提案します。

本提案手法は、敵対的生成ネットワークGANを用いて、あるドメインから他のドメインへのリターゲティングを学習します。データ駆動型メソッドは人間の介入を必要としないため、大量のビデオを素早く変換することが可能です。顔から顔は、OpenPoseを用いて姿勢推定しています。

このことで、顔の表情と動きを人物から別の人物(またはキャラクタ)に変換したり、白黒フィルムをカラーに変換したり、花の開花を別の花へ変換させたり、風が強い風景動画を穏やかな風の風景動画に変換したり、などが可能になります。