OpenAIは、AIシステムの安全性を高めるため、エージェント同士が互いに論争する訓練法を発表しました。

論文:AI safety via debate

著者:Geoffrey Irving, Paul Christiano, Dario Amodei

エージェントが人間の価値観や嗜好に合わせるよう学ぶことは、AIシステムが安全であることを保証する上で重要なことだと考えています。そこで、本稿はゼロサムのディベートゲームを介して訓練することで、エージェントを人間の価値観や嗜好に合わせるための1つのアプローチとして提案します。

本提案手法は、討論者2人のエージェントと裁判官1人のエージェントが登場し、1人の討論者が正直者であり裁判官を正しく推測させようとしますが、もう1人の討論者は裁判官を間違ったものにしようと敵対し、そして、裁判官が2人の意見から回答を予測するというものです。

トレーニングには、0から9までの複数の手書き数字の画像から構成されたデータセット「MNIST」を使用します。

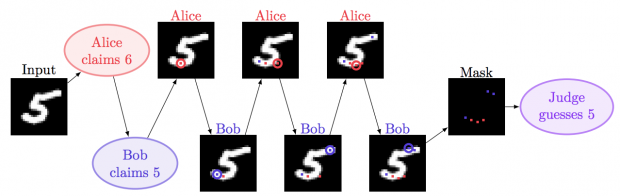

上図では、討論者アリスとボブが「5」のイメージを見て、ボブは裁判官に「5」を正しく納得させようとし、アリスは裁判官を「6」と思うように騙そうとします。説得するために、裁判官に見せるピクセルをいくつか交互に提示します。

裁判官は、全体像の画像を見ることはできません。その代わり、交互に見せられる複数のピクセルから予測します。

アリスは、「6」に思わせるため下のカーブ部分を重点的にピクセル表示する一方で、ボブは右上などを重点的にピクセル表示しています。

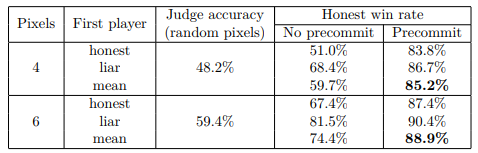

精度結果は、ランダムに選択された6ピクセルの提示で59.4%、4ピクセルの提示で48.2%の正確なジャッジが報告されたのに対して、本提案の事前に数字を宣言し選択した6ピクセルの提示で平均88.9%に向上、同じ条件で4ピクセルの提示で平均85.2%に向上したことを報告しました。

平均とは、どちらの討論者が最初に提示するかによって勝率が変わるので、それぞれが最初にプレイした数値からの平均値です。ちなみに、虚偽プレイヤ先行の方が勝率が高いです。

人間たちで出来るプロトタイプWebサイト

次のステップとしては、より複雑な画像へのテストですが、現在はさらに高度な推論が必要なため行っていません。その代わり、人間たちでテストできるプロトタイプのWebサイト「Debate Game」を作成しました。

公開しておりブラウザ上で試すことができます。任意の画像を選択し、討論者2人と裁判官1人で作業するというものです。1人の討論者が真実を述べ、もう一方の討論者が虚偽を述べ、裁判官が予測します。画像は、討論者の2人にしか見えません。

(画像出典:File:Beagle puppy sitting on grass.jpg – Wikimedia Commons)

上のGIFでは、赤は画像が犬であると主張し、青は猫であると主張し論争しています。画像内の任意に指定したボックスを基に裁判官と自然言語で話すことができます。また、全体を通して1回だけ1ピクセルを明らかにすることができます。