深セン大学、華中科技大学、ヘブライ大学、ルアビブ大学の研究者らは、見本のテクスチャから見本に類似したより大規模で現実的なテクスチャに拡張することができるテクスチャ合成法を発表しました。

論文:Non-Stationary Texture Synthesis by Adversarial Expansion

著者:Yang Zhou, Zhen Zhu, Xiang Bai, Dani Lischinski, Daniel Cohen-Or, Hui Huang

GitHub – jessemelpolio/non-stationary_texture_syn

(中心が見本で、両サイドが本提案手法を用いた出力結果)

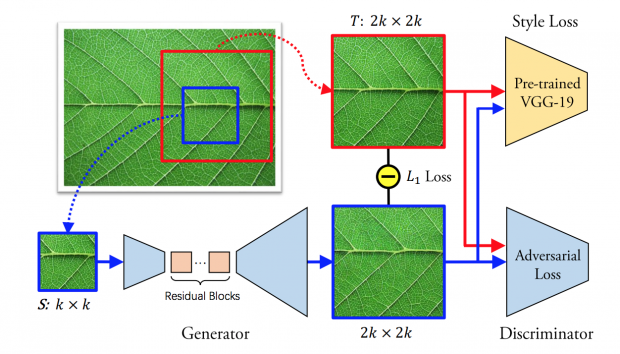

本稿は、任意のテクスチャ見本からGAN(Generative Adversarial Network,敵対的生成ネットワーク)を用いて、入力の見本テクスチャによく似たより大規模で現実的なテクスチャを生成するように訓練したテクスチャ合成のためのアプローチを提案します。

ネットワークでは、生成器が見本のテクスチャ(約600×400ピクセル)を2倍に拡大することを学習し、識別器が生成器から作成されたものか、そうでないかを評価することで、精度を向上させます。

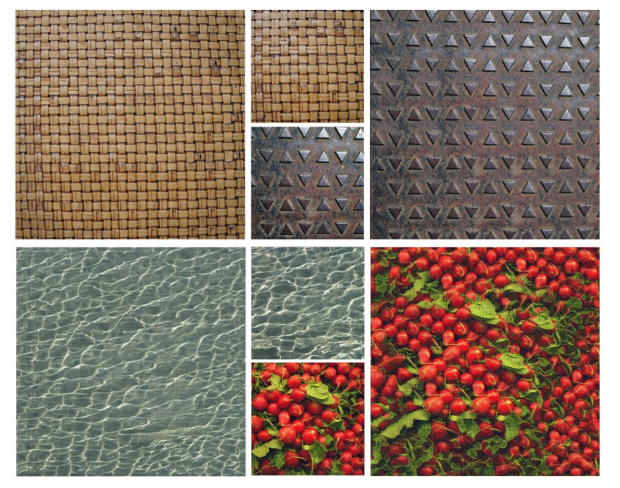

本研究では、孔雀の羽根、年輪、川の水の波紋、コンクリートの壁、葉の模様などの複雑な模様でテストされ、以下のように連続的で自然に表現することを可能にしました。

(中心が見本で、両サイドが本提案手法を用いた出力結果)

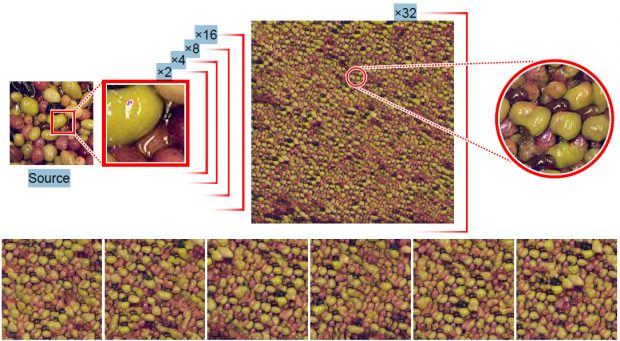

また、大きな拡張として、64×64ピクセルの見本テクスチャから2048×2048の結果を出力したのが下の画像です。

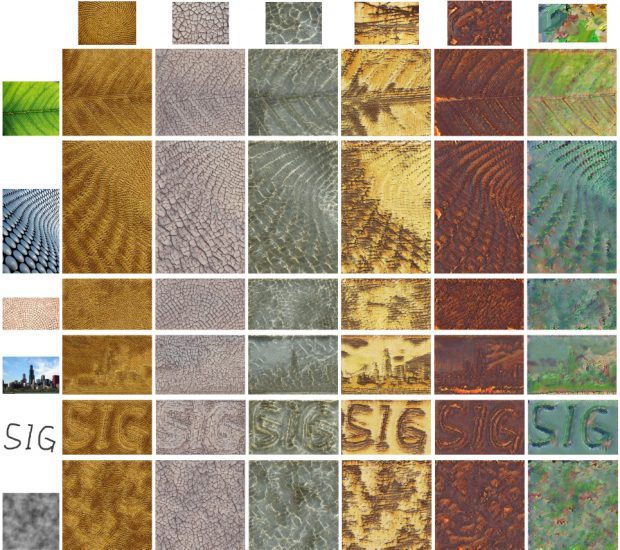

加えて、1つの見本テクスチャに対して、別の画像を供給することで、融合した合成画像を出力します。

(上に見本テクスチャ、左にガイド画像)

さらに、1つのソーステクスチャから複数の違う領域を抜き出しシャッフルなどして動的に表現した出力も報告します。