スコットランドのエディンバラ大学、Adobe Researchの研究者らは、ニューラルネットワークを用いて動作データから四足歩行キャラクタにおける自然なアニメーションを生成する新たな手法を発表しました。

論文:Mode-Adaptive Neural Networks for Quadruped Motion Control

著者:HE ZHANG, SEBASTIAN STARKE, TAKU KOMURA, JUN SAITO

GitHub:sebastianstarke/AI4Animation: Character Animation in Unity3D using Deep Learning and Biologically-Inspired Artificial Intelligence

本稿では、ニューラルネットワークを用いてリアルタイムに四足歩行キャラクターを制御し、アニメーションを生成できるアーキテクチャを提案します。

提案手法は、Gating networkとMotion prediction networkの2種類から構成されたMode-Adaptive Neural Networks (MANN) と呼ぶ、エンドツーエンドでトレーニング可能なニューラルネットワークアーキテクチャです。

事前に四足歩行モーションキャプチャデータ(歩容、ジャンプや座る等)を処理しアクションラベルを追加します。入力として前フレームの姿勢、前後12フレームの軌道や動作ラベルを与え、出力として現在のフレーム推定された姿勢を算出します。

これら入出力のデータセットを使用してエンドツーエンドで訓練し、実行時は前フレームとユーザが入力する制御信号を使用してリアルタイムにキャラクタのアニメーションを生成します。

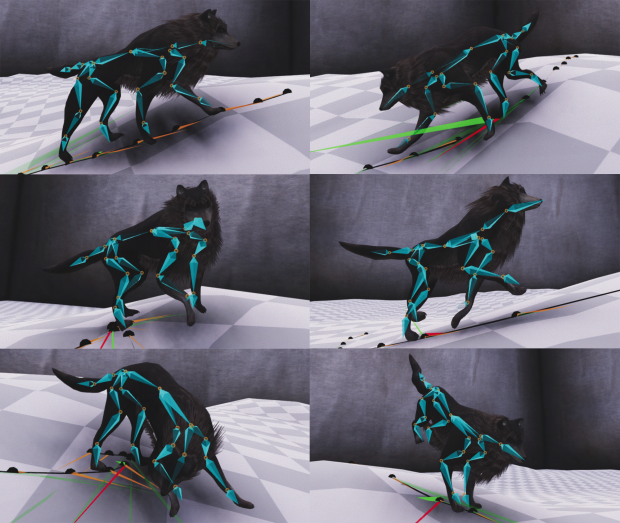

実験で使用された犬のモデルは、27本の骨格モデルによる81自由度を持っています。Unityのフレームワーク上で組まれた実行プログラムにより、四足歩行キャラクターをインタラクティブにコントロールし、滑かな動きを生成できます。