カリフォルニア大学とFacebook AI Researchによる研究チームは、触覚センサーとdeep learningを用いて、触覚を予測することでロボットの操作を制御するフレームワーク「tactile MPC(tactile model-predictive control)」を発表しました。

論文:Manipulation by Feel: Touch-Based Control with Deep Predictive Models

著者:Stephen Tian, Frederik Ebert, Dinesh Jayaraman, Mayur Mudigonda, Chelsea Finn, Roberto Calandra, Sergey Levine

所属:Department of Electrical Engineering and Computer Sciences,University of California, Facebook AI Research

人間の手による操作は、物体を触れる触覚により正確に行うことが出来ます。しかしながら、ロボットにこれら効果的なタッチセンシングを実装し器用にタスク処理させるのは困難なのが現状です。そこで、本論文ではMITが研究する高解像度触覚センサー「GelSight」とdeep recurrent neural networkを用いることで、触覚センサー入力から触覚サーボを実行することを学ぶための教師なしフレームワークを提案します。

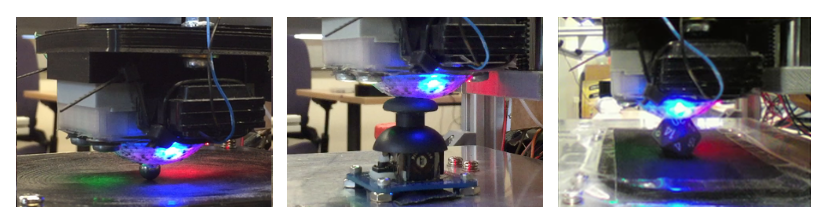

GelSightは、先端がエラストマーベースのゲル表面で構成されており、内部から3色のLEDを照らすことで物体に接触した際の凸凹を計測し3次元構造を認識する仕組みのセンサーです。RGB画像からなるコンピュータビジョンベースの触覚センサーです。

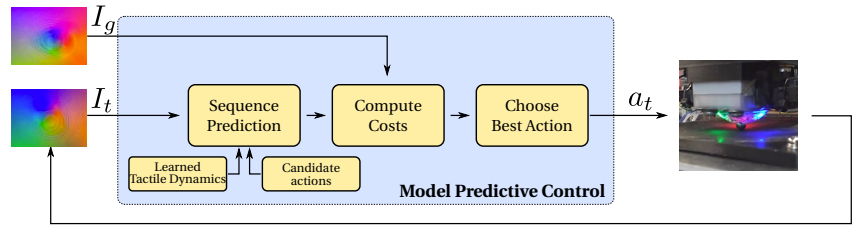

このセンサーを用いて、画像を予測するように訓練するのが本提案アプローチです。そして、未来のビデオフレームを予測することで、最適な制御ポリシーを推定し行動を決定します。これらモデルを訓練するために、事前にランダム操作からの大規模な軌跡データセットを収集しています。

訓練したモデルを用いることで、ユーザ指定したゴール位置(画像)までが予測され最適化されたアクションを実行します。これにより、触覚から各物体を繊細な動作で再配置することを可能にします。実験では、小さな銀玉を指定の位置に転がす、アナログスティックを制御する、20面ダイスを指定の位置まで回転させる、これらのテストで器用さを実証します。