ジョージ・メイソン大学や日本放送協会などによる研究チームは、VRユーザが現シーンでナビゲーションによる支援を必要としているかを視線追跡から予測する手法を発表しました。

論文:Lost in Style:Gaze-driven Adaptive Aid for VR Navigation

著者:Rawan Alghofaili, Yasuhito Sawahata, Haikun Huang, Hsueh-Cheng Wang, Takaaki Shiratori, Lap-Fai Yu

所属:George Mason University, Japan Broadcasting Corporation, University of Massachusetts-Boston, National Chiao Tung University, Facebook Reality Labs

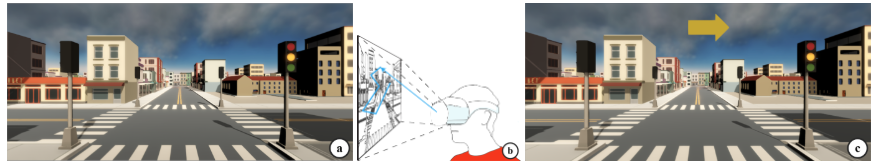

本論文は、VRにおいて視線追跡を分析することで、ユーザのナビゲーション支援が必要かどうかを予測するためのアプローチを提案します。VRナビゲーションには、矢印を用いたり、ミニマップを用いたり、経路を可視化したりなど表示方法にはいくつもあります。

ユーザが、上記のようなナビゲーションを現シーンで欲しいと感じた場合、得てしてナビゲーションによるガイドがなくイライラから没入感を下げることがあります。開発者が気が付いていない場合もありますし、ナビゲーションを入れると環境を損なうとして入れていない場合などもあります。

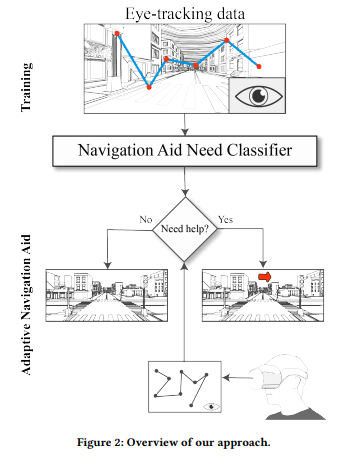

そんな、矛盾を解決するため、ユーザに適した効率的なナビゲーション表示を実行しようという研究が本提案になります。本提案は、ユーザの視線を追跡し、そのデータを分析することで、ナビゲーションを表示するかしないかを決定します。

ユーザから収集したアイトラッキングデータを使用して、データセットを構築し、ユーザがナビゲーション支援を必要としていることを予測するために訓練します。この予測を行うことで、ユーザの没入感を維持しつつナビゲーションを挿入することができ、VRデザインにおいてナビゲーション支援のバランスを確保することを可能にします。