UCバークレーやFyusion Inc.などによる研究チームは、スマートフォンで撮影した複数の画像から実世界の3Dシーンを再構築するより効率的なレンダリングパイプラインを発表しました。

論文:Local Light Field Fusion: Practical View Synthesis with Prescriptive Sampling Guidelines

著者:Ben Mildenhall,Pratul Srinivasan, Rodrigo Ortiz-Cayon,Nima Khademi Kalantari, Ravi Ramamoorthi ,Ren Ng, Abhishek Kar

所属:UC Berkeley, Fyusion Inc. Texas A&M, UC San Diego

GitHub – Fyusion/LLFF: Code release for Local Light Field Fusion at SIGGRAPH 2019

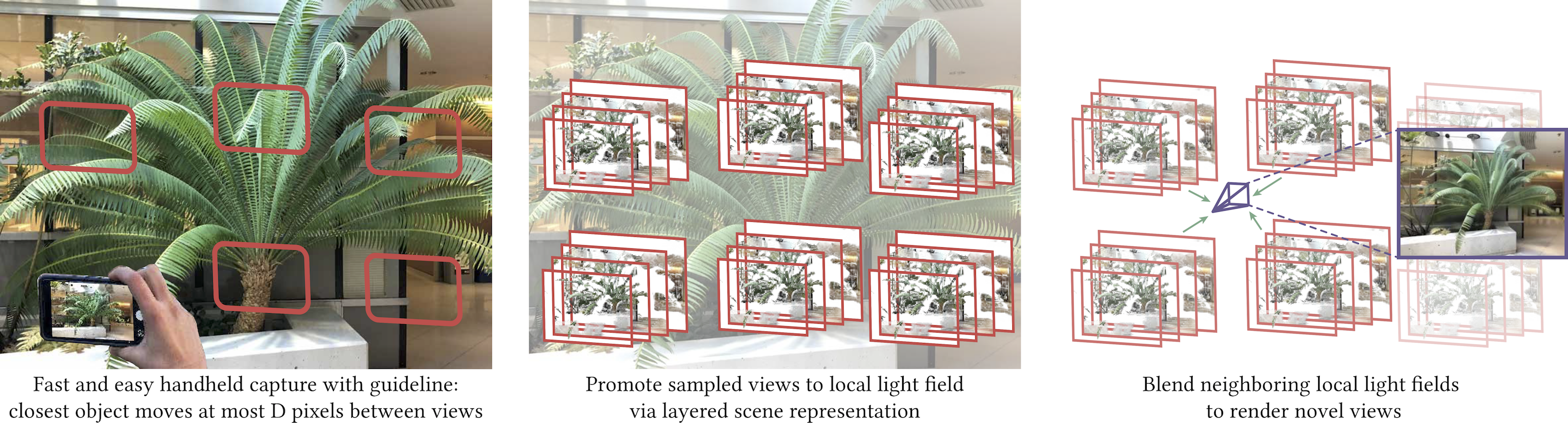

スマートフォンで格子状に撮影して(左)、撮影したサンプルビューをレイヤー化を通してローカルライトフィールドに変換(中央)、隣接するローカルライトフィールドを統合することで合成ビューを生成する(右)。

本提案手法を用いてレンダリングした出力結果。

実世界の高品質な3Dシーンを画像ベースでレンダリングする場合、高密度のビューサンプリングを用いて補間し合い生成する手法があります。しかしながら、大量の画像をキャプチャする課題があります。また、複数枚の画像をランダム撮影して、捉えきれない画像は推定して補うアプローチも行われていますが低いパフォーマンスでしか出力できません。そこで本論文では、スマートフォンで不規則だけど格子状に撮影したいくつかの写真から高品質の3Dシーンをリアルタイムに生成する高速アルゴリズムを検証します。

本提案は、スマートフォンで格子状に撮影した複数枚の画像を入力に、実世界の3Dシーンを合成するアプローチを採用します。具体的には、deep learningを用いて各入力画像をローカルライトフィールドに変換し、隣接するローカルライトフィールドをブレンドすることによって新しいビューを合成します。

ユーザは、スマートフォンを用いてガイドラインに習った撮影をするだけで高品質な実世界の3Dシーンを作成することができます。また本手法は、高密度のビューサンプリングを用いて実行する手法と比較しても最大4000枚少ない入力画像で同程度の品質を出力できることも実証しました。