MPI-Infやスタンフォード大学の研究チームは、単一のカメラで撮影した映像から、ゆったりと着用する衣服を含めた人の動きをリアルタイムに3D再構築する機械学習を用いたフルボディパフォーマンスキャプチャシステム「LiveCap」を発表しました。

論文:LiveCap: Real-time Human Performance Capture from Monocular Video

著者:Marc Habermann, Weipeng Xu, Michael Zollhoefer, Gerard Pons-Moll, Christian Theobalt

所属:Max Planck Institute for Informatics, Stanford University

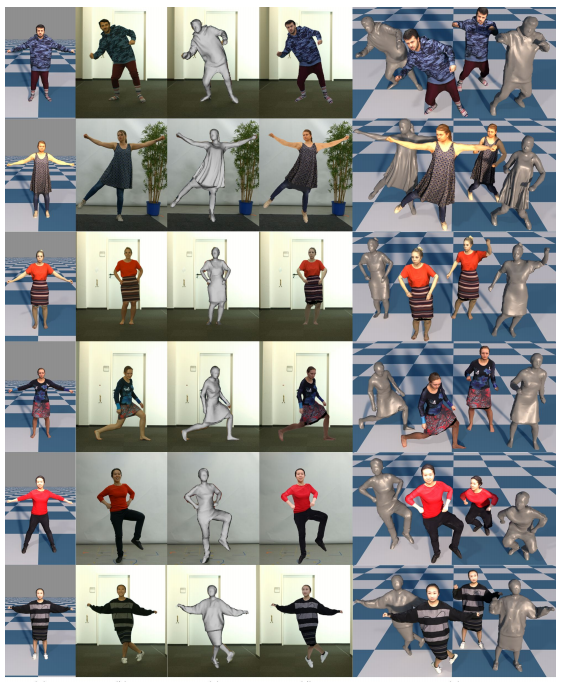

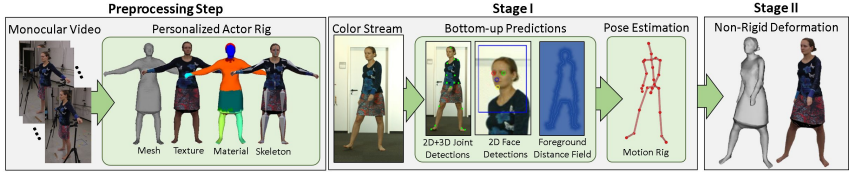

本論文は、単眼カメラで撮影したRGBビデオを入力に、着衣含めて人の動きを再構築するマーカレスパフォーマンスキャプチャアプローチを提案します。本提案手法は、姿勢推定と非剛体追跡の2段階パイプラインで構成されます。

第1段階(前処理)では、撮影したビデオを入力に、CNN(Convolutional Neural Network)を用いて2Dおよび3D骨格関節や顔ランドマーク検出から、3D姿勢を推定しテクスチャ付きアクターモデルテンプレートを作成します。

第2段階では、RGBデータからの非剛性分析、合成追跡のための新規なリアルタイム対応アルゴリズムを用いて、前処理段階で得られた形状テンプレートを活用し、肌および密着していない衣類の非剛性3D変形を生成します。

これにより、関節のある人の動きと、肌と衣服の非剛性の変形を自動的に推定することで、リアルタイムのフルボディパフォーマンスキャプチャを実現します。将来的には、1台のカメラから顔の表情、手の動き、髪の動きを同時に再構築したいとしています。