ジョージア工科大学とGoogle Brainの研究者らは、強化学習と物理シミュレーションを使用して服を着るヒューマノイドキャラクタをアニメートするシステムを発表しました。

論文:Learning to Dress: Synthesizing Human Dressing Motion via Deep Reinforcement Learning

著者:Alexander Clegg, Wenhao Yu, Jie Tan, C. Karen Liu, Greg Turk

本論文は、Deep Reinforcement Learning(深層強化学習/deepRL)を用いて、より自然な着衣アニメーションを生成するアルゴリズムを提案します。

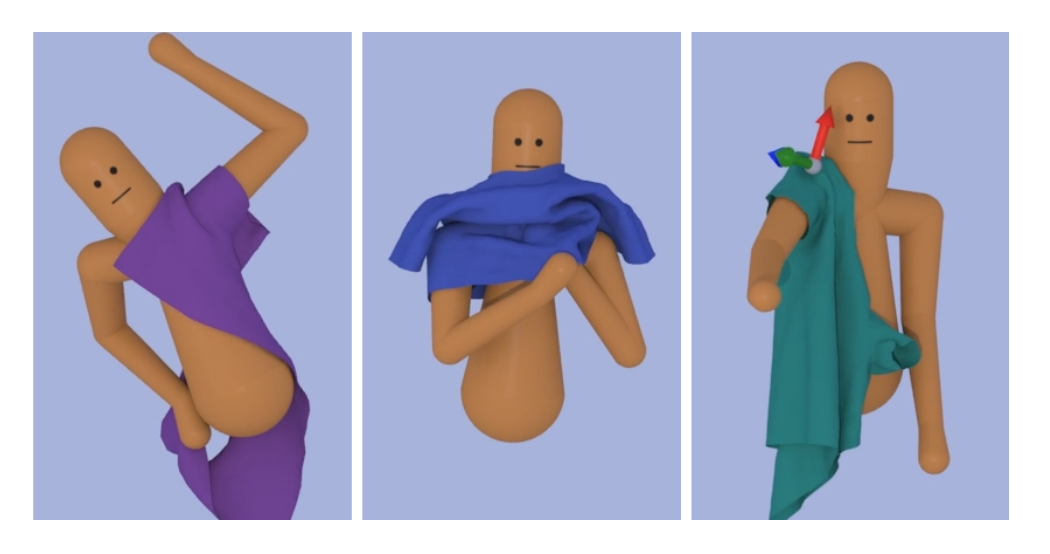

本提案手法は、着衣制御ポリシーを学習するためのdeepRLフレームワークに、布シミュレーションを組み込むことで実現します。具体的には、シャツの端をつかみ、シャツの開口部に手を入れて、袖を通して手を押すなどの様々なサブタスクに分解し、各サブタスクの制御ポリシーを個別に学習し、各サブタスクの入力分布を以前のサブタスクの出力分布と一致させることで実現します。

ポリシーは、人間モデルの関節角と速度、衣服の頂点位置、触覚(衣服の内側と接触しながら着衣するため)、表面情報、タスクベクトルなどが含まれます。また、タスクがポリシーの切り替えによって失敗しないようにするために、あるサブタスクからの出力状態の分布をシーケンス内の次のサブタスクの入力分布に一致させるポリシーシーケンシングアルゴリズムを導入します。

これにより、ヒューマノイドキャラクタがTシャツやジャケットなどの衣服を、より自然に着衣することを可能にします。