KAISTとPOSTECHによる研究チームは、画像における特定の領域を変換できるGAN(Generative Adversarial Network)を用いた手法「Instance-aware GAN (InstaGAN)」を発表しました。

論文:InstaGAN: Instance-aware Image-to-Image Translation

著者:Sangwoo Mo, Minsu Cho, Jinwoo Shin

所属:KAIST, POSTECH

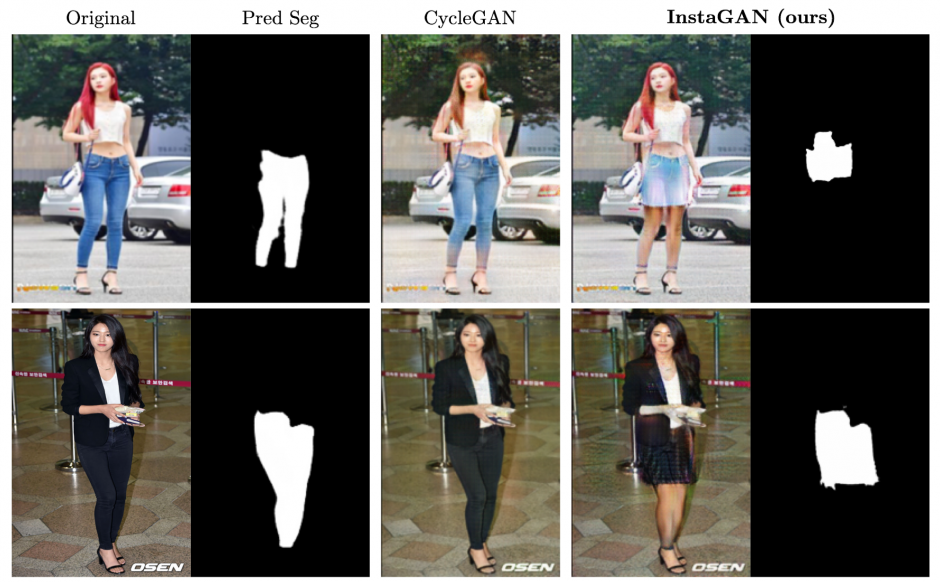

左:パンツからスカートへ変換、右:羊からキリンへ変換

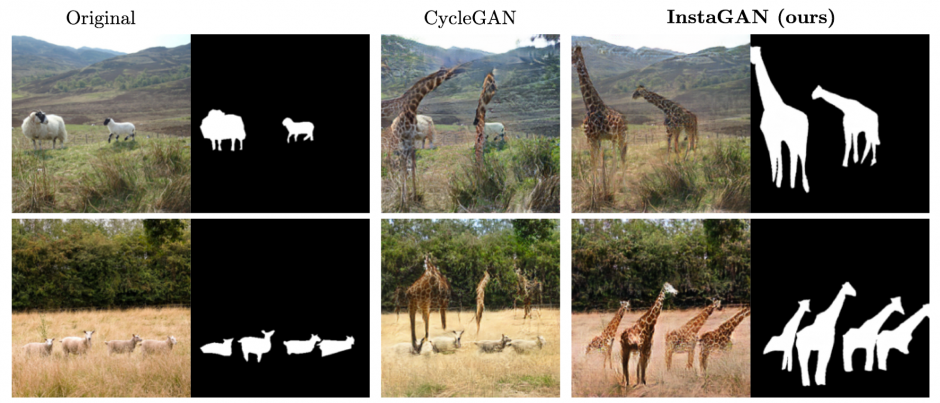

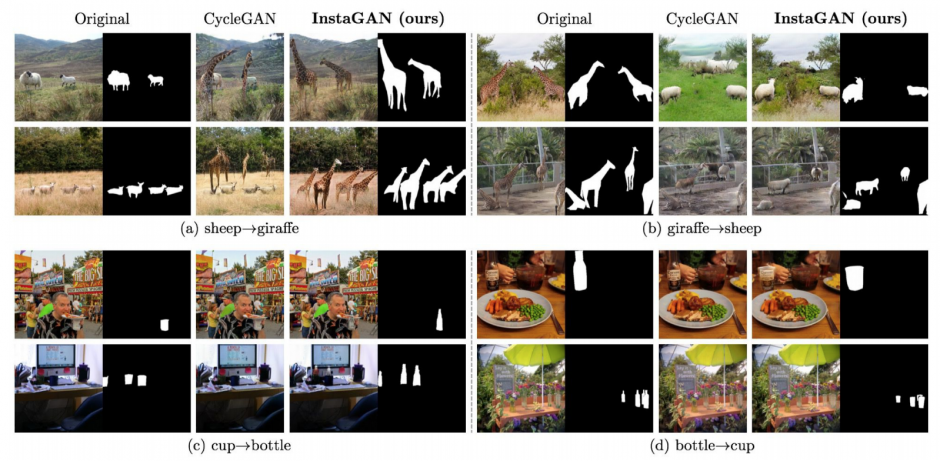

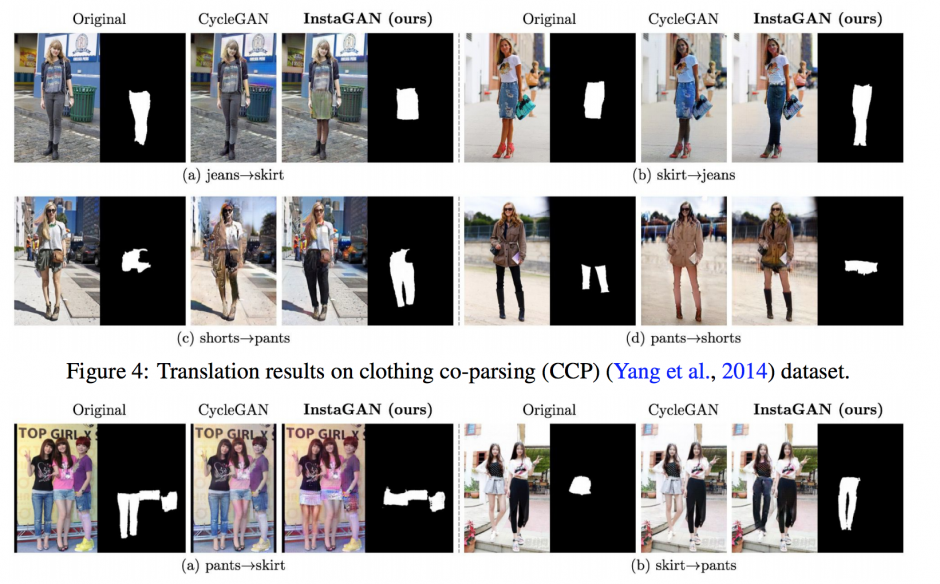

左:インプット画像、中央:CycleGAN、右:InstaGAN(本提案手法)

本論文は、画像内の特定の領域をより自然に変換させるGANを用いるマルチインスタンス変換を提案します。本提案手法は、前研究の画像から画像に変換する「CycleGAN」をベースに、ドメインセットおよびインスタンス属性のセット(ここではオブジェクトセグメンテーションマスク)から画像内の対象を変換します。

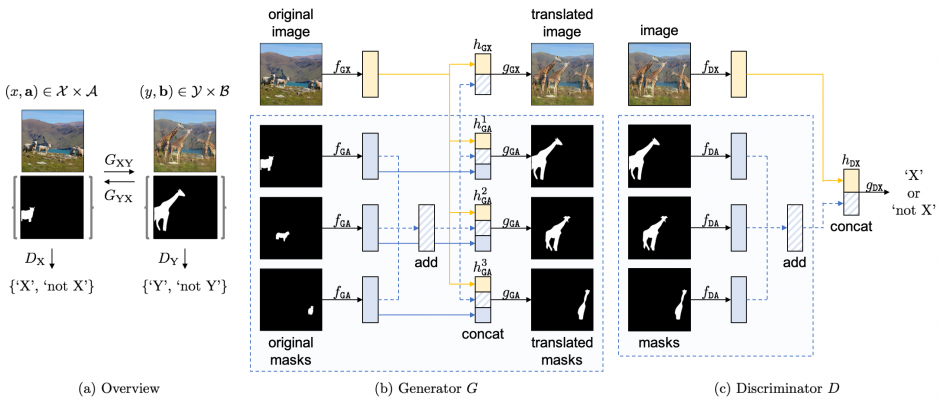

GANは、画像とインスタンスマスクを別々のネットワークでエンコードするように構築されており、画像とそれに対応するインスタンス属性のセットの両方を変換するニューラルネットワークアーキテクチャです。

Generatorにより、画像とマスクから特徴を抽出し、Concatを通して画像とマスクを変換、Discriminatorで画像とマスクそれぞれを判別します。

これにより、ターゲットインスタンスを変換しながらバックグラウンドコンテキスト(変換後も背景)を保持する結果を出力することを可能にします。以下、出力結果です。

GitHub – sangwoomo/instagan: PyTorch implementation of “InstaGAN: Instance-aware Image Translation”