清華大学などの研究チームは、1台の深度カメラと慣性計測装置(inertial measurement unit、IMU)を用いて、服を着ている人の全身運動を再構築する新たなパフォーマンスキャプチャシステム「HybridFusion」を発表しました。

論文:HybridFusion: Real-Time Performance CaptureUsing a Single Depth Sensor and Sparse IMUs

著者:Zerong Zheng, Tao Yu, Hao Li, Kaiwen Guo, Qionghai Dai, Lu Fang, Yebin Liu

所属:Tsinghua University, Beihang University, University of Southern California, Google, Tsinghua-Berkeley Shenzhen Institute

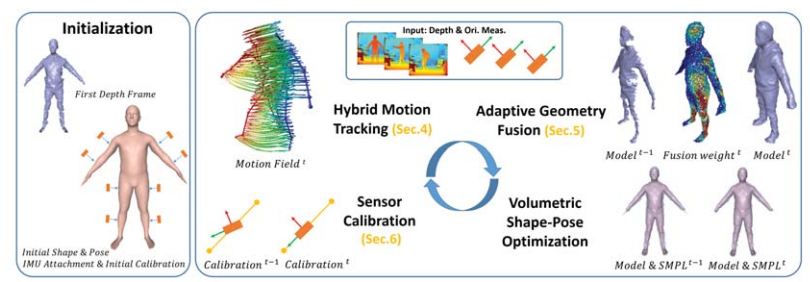

本論文は、単一の深度カメラとIMUのハイブリッドセンサを使用して、人の表面形状と内部形状を同時に再現するリアルタイムのパフォーマンスキャプチャシステムを提案します。

デプスマップとIMU測定値をもとに、新しいハイブリッドモーショントラッキングアルゴリズムを使用して、骨格運動と表面非剛体変形を同時に追跡します。深度カメラでは捉えきれない高速な動きによる隠蔽などを、IMUによる高いフレームレートの方向情報を提供することで補います。ユーザの腕に8つ、足に4つのIMUを付け、方向測定を行います。

本パイプラインは、ハイブリッドセンサによるモーショントラッキングデータをもとに、適応的に形状を融合し、形状の最適化、センサキャリブレーションを順次実行することで実現します。

本システムは、容易で安価な機材できることから、自宅でも高品質の4Dパフォーマンスをキャプチャすることができるとしています。