南カリフォルニア大学、USC Institute for Creative Technologies、Pinscreen、Microsoft Research Asiaの研究者らは、deep learningを用いて、1枚の2D画像から髪の毛の3Dモデルをより自然に生成するための手法を発表しました。

論文:Single-View Hair Reconstruction using Convolutional Neural Networks

著者:Yi Zhou, Liwen Hu, Jun Xing, Weikai Chen, Han-Wei Kung, Xin Tong, Hao Li

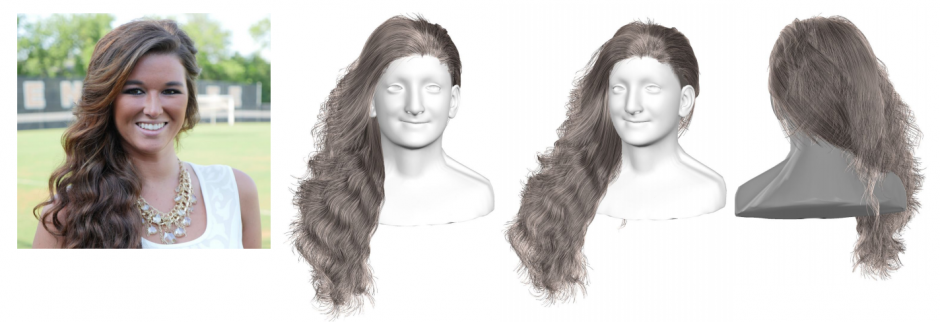

本稿は、単一視点の画像から、全体のヘアジオメトリをリアルタイムに生成するためのニューラルネットワークを用いたアプローチを提案します。

本提案手法は、HairNetと呼ぶアーキテクチャで構成されており、ヘアマスクの推定を入力に各ピクセルの方向を計算し、さらに顔検出による頭と体のマスクも加えて入力とし、高密度のヘアモデルを再構築します。エンド・ツー・エンドのネットワークを訓練します。

現段階では、エキゾチックな髪型はうまく再現することはできませんが、より大量のヘアデータセットを構築すれば緩和するものとしています。