インド,ニューデリーにあるTCS Research and Innovation(R&I)は、内蔵カメラのRGB画像入力だけでスマートフォンなどのモバイル機器でAR指先追跡と手のジェスチャ認識を高精度かつリアルタイムに実行する機械学習フレームワークを発表しました。

著者: Varun Jain, Gaurav Garg, Ramakrishna Perla and Ramya Hebbalaguppe

所属: TCS Research, India

過去数十年の間にデスクトップからモバイルコンピューティングへと移行し、デバイスとの対話方法もキーボードとマウスからタッチと音声、そしてジェスチャインタフェースへと進化しました。空中ジェスチャは、ARとのやり取りにとりわけ効果的です。

そこで、本論文ではモバイル内蔵単眼カメラのRGB画像を入力に、AR指先追跡と手のジェスチャ認識をリアルタイムに実行する機械学習アプローチを提案します。本アプローチは、深度センサおよび他の高価なプロセッサを用いてジェスチャコマンドを提供する装置に対する代替インタフェースとして機能します。

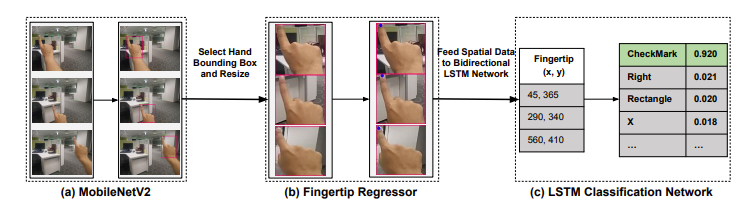

本提案は、AR向けジェスチャインタフェースのためのニューラルネットワークモデルに基づいています。具体的には、入力として単一のRGB画像をキャプチャし、手の検出用に「MobileNet V2」、指先回帰用のTCSアーキテクチャ、およびジェスチャ分類用のBi-LSTMを使用してトラッキングを実行します。

その結果、フレームワークはモバイルデバイス上でリアルタイムに実行され、平均待ち時間0.12秒「EgoGestAR」データセットで80%の分類精度を達成しました。このアルゴリズムは、Androidデバイスに埋め込むことができ、スマートフォンに適合するタイプのARゴーグル(ビデオシースルーヘッドマウント)と共に使用することができます。

本論文は、2019年1月に開催されたArtificial Intelligence conference (AAAI)にて発表されました。また、同ラボはスコットランド,グラスゴーで5月に開催されるCHI 2019にも別の空中ジェスチャフレームワークを発表します。これもスマートフォン向けのジェスチャインタフェースです。

- 論文: AirPen: A Touchless Fingertip Based Gestural Interface for Smartphones and Head-Mounted Devices

- 著者: Varun Jain and Ramya Hebbalaguppe

- 所属: TCS Research & Innovation, India

- 論文: FingertipCubes: an inexpensive D.I.Y wearable for 6-DoF per fingertip pose estimation using a single RGB camera, SIGGRAPH Asia 2018

- 著者: Ojaswi Gupta and Ramya Hebbalaguppe

- 所属: TCS Research & Innovation, India