ザールラント大学などの研究チームは、深度センサを用いて、親指と指の相互作用のためのジェスチャ認識システム「FingerInput」を発表しました。

論文:FingerInput: Capturing Expressive Single-HandThumb-to-Finger Microgestures

著者:Mohamed Soliman, Franziska Mueller, Lena Hegemann, Joan Sol Roo, Christian Theobalt, Jürgen Steimle

所属:Saarland University, Max Planck Institute for Informatics

本論文は、片手における親指から他の指への組み合わせで多様なマイクロジェスチャを可能にするシステムを提案します。本提案手法は、身体に身に着けた深度センサを用いて、手の姿勢をリアルタイムに検出し、指の屈曲や接触位置の関係性によって、幅広いマイクロジェスチャを生成します。FCN(Fully Convolutional Networks)を用いることで、指と指の相互作用において直線や回転など接触を高精度に分類することができます。

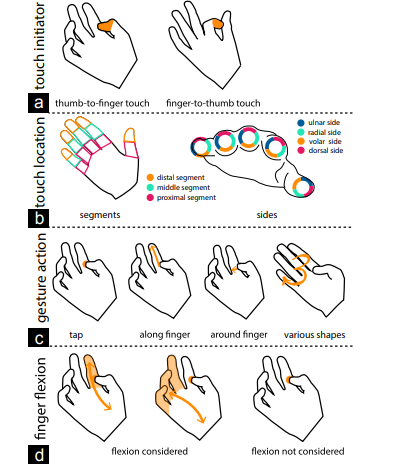

マイクロジェスチャの認識システムは、以下の4つの方法の組み合わせで判断されます。

- タッチを開始する指(下図のa)

- タッチする位置(下図のb)

- ジェスチャ動作(下図のc)

- 指の屈曲(下図のd)

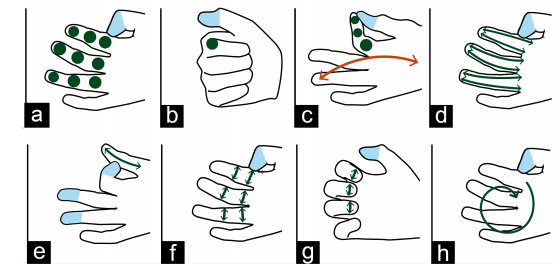

どの指が触れているか、他の指のどの位置に触れているか、どのようなタッチアクションが実行されているか、どの指が屈曲しているかによって区別されます。また、8つのジェスチャクラスに分類されます。

(a)親指で他の指をタップ、(b)拳をタップ、(c)タップとフラップ、(d)親指を他の指の上で縦にスライド、(e)他の指で親指の上を縦にスライド、(f)親指で他の指の上を横にスライド、(g)爪の上を親指で横にスライド、(h)親指で円を描く。

実験では、指のジェスチャ認識で91%の高い精度を示しました。