大阪大学の研究チームは、遠隔地に投影した仮想ハンドに触覚フィードバックを呈示するインタラクティブシステム「fARFEEL」を発表しました。

論文:fARFEEL: Providing Haptic Sensation of Touched Objects using Visuo-Haptic Feedback

著者:Naruki Tanabe, Yushi Sato, Kohei Morita, Michiya Inagaki, Yuichi Fujino, Parinya Punpongsanon, Haruka Matsukura, Daisuke Iwai, Kosuke Sato

所属:Graduate School of Engineering Science, Osaka University

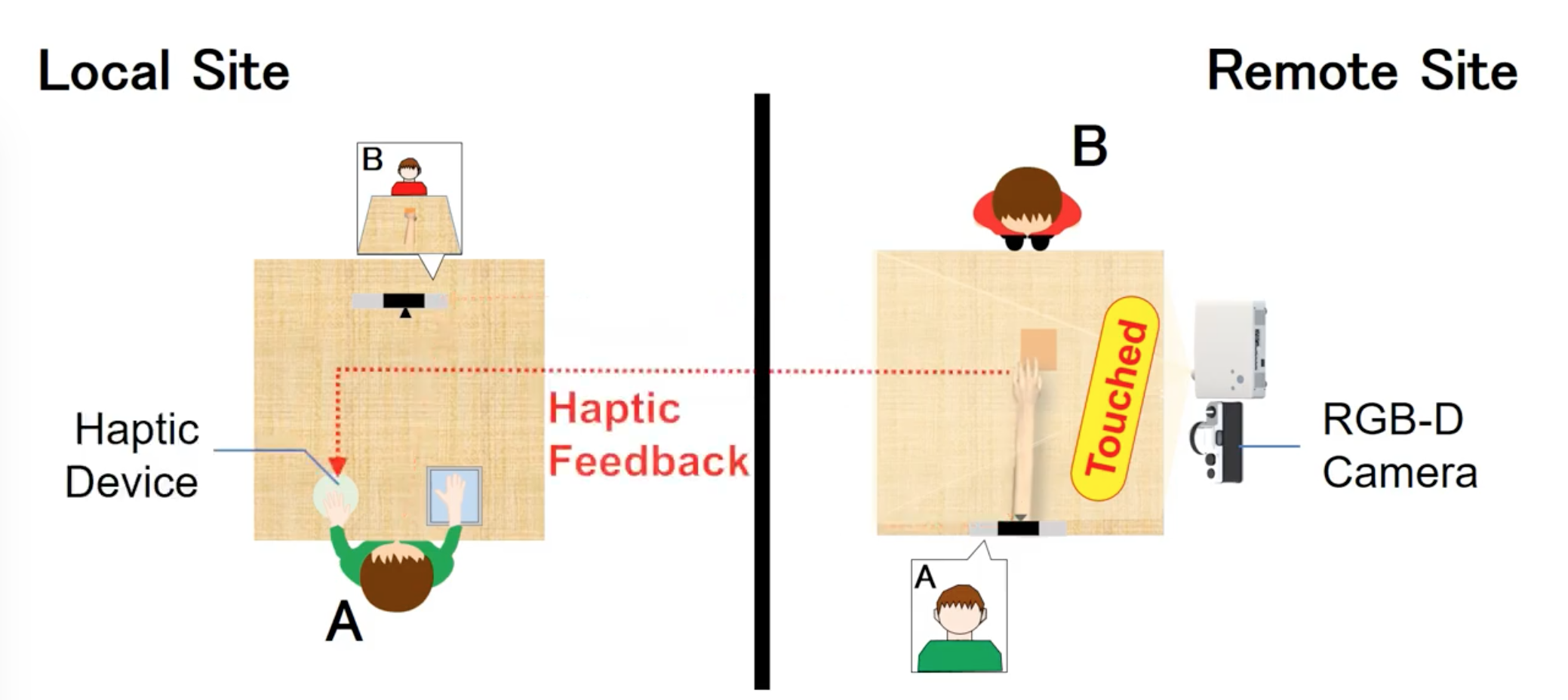

本論文は、投影した仮想ハンドに触覚を呈示するアプローチを提案します。本提案は、ローカルユーザが遠隔地にいる人と実世界に投影重畳された仮想ハンドによるコミュニケーションを可能にするプロジェクションマッピングインターフェースです。システムは、ローカルサイトとリモートサイトの2つのサイトで構成され、ローカルユーザは、タッチパネルを用いてリモートサイトに投影された仮想ハンドを操作し、実物体に触れたり、仮想物体を移動させたりするといったインタラクションを起こします。

インタラクションを起こす中で、リモートサイトの実物体に触れると触覚装置を介して触覚がローカルユーザにフィードバックされます。触覚装置は、仮想ハンドを操作する手とは別の手に呈示されます。別の手に触覚を呈示することで、ローカルユーザは操作を妨げられることなく、ローカルサイトの物体とインタラクションを起こすことができます。ローカルサイトでは、プロジェクタとRGB-Dカメラが頭上にセットされ、RGB-Dカメラから実物体の深度情報を取得します。ローカルサイトの実物体に触れると、取得した深度情報から高さをマッピングし、レンダリングすべき高さを決定し、実物体の凹凸の感触などを振動刺激や刺突刺激などに出力します。

また、振動による触覚刺激だけでなく、投影する仮想ハンドの動きを変化させ視覚的にも刺激を呈示します。例えば、凹凸の実物体に触れると、仮想ハンドの指が震えるように動いたり、柔らかい実物体に触れると、仮想ハンドの指の周りに変形パターンを投影したりなどします。この視覚刺激と触覚刺激を組み合わせることにより、より現実的な触覚フィードバックを再現します。将来的には、温度や摩擦などの他の触覚情報も検討します。

デモ動画では、将棋の駒を動かす様子、扇子の凸凹を触る様子、柔らかいどら焼きを押す様子などを確認することができます。