東京大学による研究チームは、ユーザの視線追跡に基づいて、ライブシーンと記録/編集シーンを時間的・空間的に混合させるVRシステムを発表しました。

論文:EyeHacker: Gaze-Based Automatic Reality Manipulation

Daichi Ito(The University of Tokyo)

Sohei Wakisaka(The University of Tokyo)

Atsushi Izumihara(The University of Tokyo)

Tomoya Yamaguchi(National Institute of Technology,Ishikawa College)

Atsushi Hiyama*(The University of Tokyo)

Masahiko Inami(The University of Tokyo)

*Also with RIKEN Center for Advanced Intelligence Project.

本論文は、同じ空間におけるライブシーンと記録シーンとを気付かれずに自動差し替えする視線追跡ベースのVRシステムを提案します。先行研究として、代替現実システム(Substitutional Reality System, SR)が挙げられます。VRヘッドマウンテッドディスプレイに現在のライブシーンを映し出し、その場所で予め撮影しておいた記録シーンに差し替えることで、ユーザの主観的現実を操作するシステムです。しかしながら、ライブシーンと記録シーンを差し替える際、両シーン間のギャップが目立つと差し替えはできません。差し替わったと気付かれるからです。その為、差し替えの適切なタイミングは時には提供者側が判断して、手動で差し替えを実行しなければなりません。

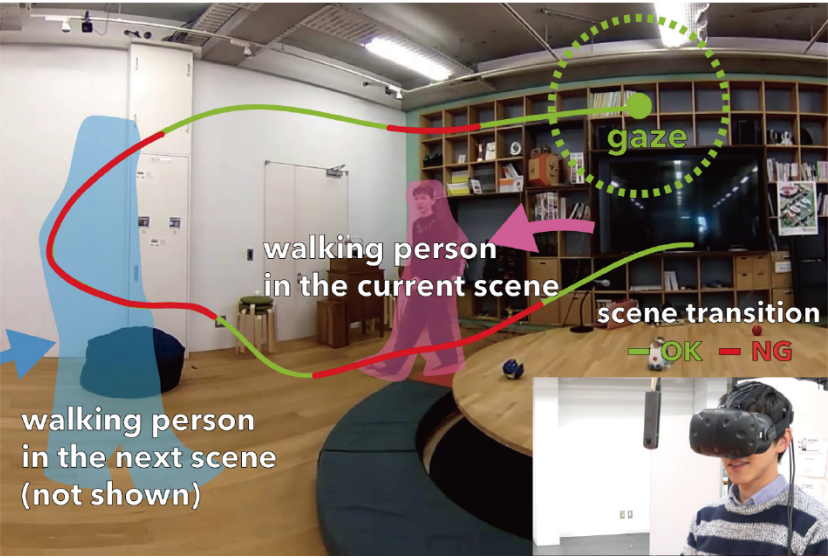

本提案システムは、その差し替え判断をユーザの視線追跡に基づいて最適なタイミングを決定し自動的に行います。ユーザにアイトラッカーを備えたヘッドマウンテッドディスプレイを装着させ、ライブシーンをキャプチャするためにユーザの目の前に全方向カメラを配置します。記録シーンは、予め、もしくは体験の最中に撮影します。差し替えタイミングの決定には、ユーザの視線追跡と差し替え前、差し替え先シーンの画像解析を使用します。すなわち、ユーザの注視領域において、差し替える前と後のオプティカルフローや差分画像を検証し、差し替えリスクを計算します。このリスクが小さいということは、このタイミングで映像を差し替えても、注視領域においてはシーン間のギャップが小さいことを意味します。頭部の回転速度を考慮し、問題がなければ差し替えを実行します。

これにより、自動でありながら、視覚的連続性を損なうことなくシーンの変更を連続的に実行できることを実証しました。本システムを用いることで、従来のSRでは実現が難しかった、様々な体験シナリオを実現できます。

- 周りで沢山の人が歩きまわっている。実はその人達は、異なる時間軸にいる(ライブ、数時間前、1分前、など)。

- 周りに転がっているボールを数えてみても、いつまでたっても数が合わない。

- 一箇所を注視していると、そこにあるもの(一般的に動かないであろう物体、ぬいぐるみなど)が動き出す(※差し替えリスクの計算アルゴリズムは別のものを採用)。

下記のGIFで、事例の1.と3.を確認できます。