奈良先端科学技術大学院大学や電気通信大学などによる研究チームは、食品の外観を画像変換し、ARを使用して重畳することで視覚から味覚を錯覚させるGAN(generative adversarial network)を用いたリアルタイム味覚操作システムを発表しました。

論文:Enchanting Your Noodles: GAN-based Real-time Food-to-Food Translation and Its Impact on Vision-induced Gustatory Manipulation

著者:Kizashi Nakano, Daichi Horita, Nobuchika Sakata, Kiyoshi Kiyokawa, Keiji Yanai, Takuji Narumi

所属:Nara Institute of Science and Technology; The University of Electro-Communications; The University of Tokyo

本論文は、GANを用いて、実際の食品をリアルタイムに違う食品画像へ変換することで、味覚を操作するインタフェースを提案します。本提案は、食品の外観(色やテクスチャ)をリアルタイムに変換することで、視覚的に味覚をコントロールするアプローチを採用します。

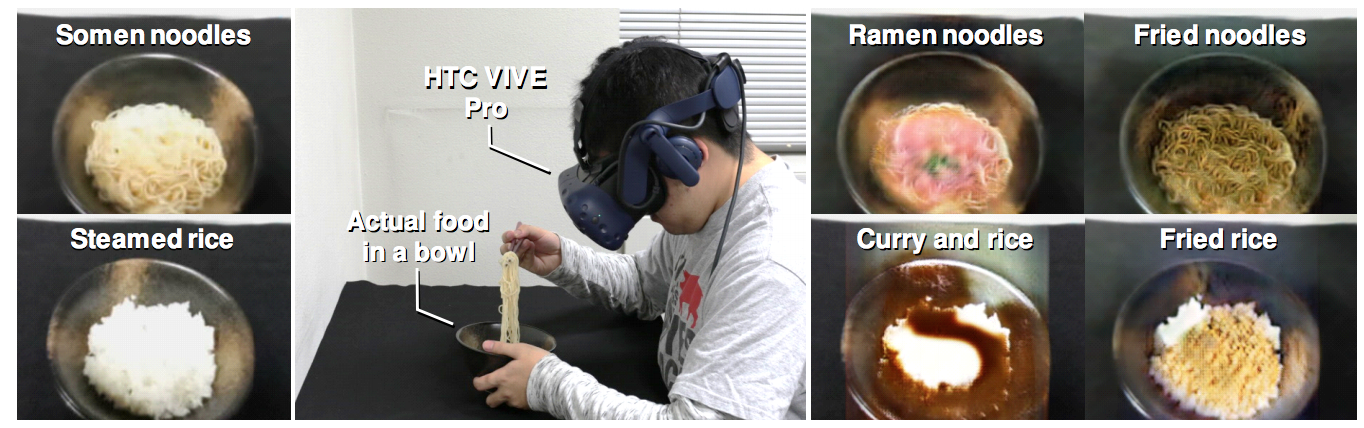

本アプローチは、まずビデオシースルーHMD(HTC VIVE Pro)のフロントカメラからRGB画像を取得するところから始め、それをサーバに送信します。サーバでは取得した画像の中心を切り取り、それを別の食品画像に変換します。イメージ変換後、現実の映像にイメージ変換処理した画像を重畳します。

食品から食品への画像変換には、StarGANベースのネットワークを用いてリアルタイムに実行されます。そのため、元の食品の変形に応じて動的かつインタラクティブに適用され、また、元の食品の視覚的特徴をある程度保ちながら調整されるため、変換後の錯覚をより自然に行うことを可能にします。さらに、例えば麺の場合、そうめんをラーメンだけでなく、焼きそば等の他の麺類に適応できる複数変換としての特徴も持ち合わせています。

ネットワークを訓練するために、5つの食品カテゴリ(ラーメン、焼きそば、白ご飯、カレーライス、チャーハン)で149,370の食品画像のデータセットを作成しました。デモ映像では、そうめんをラーメンや焼きそばに変換したり、白ご飯をカレーライスやチャーハンに変換したり、実際に食べている食品とは違う食品を食べているかのような味覚の錯覚を体験している様子がわかります。