カーネギーメロン大学による研究チームは、1台の頭部装着型カメラからの一人称視点映像を入力に自身の3D姿勢をリアルタイムに推定する手法を発表しました。

論文:Ego-Pose Estimation and Forecasting as Real-Time PD Control

Ye Yuan(Carnegie Mellon University)

Kris Kitani(Carnegie Mellon University)

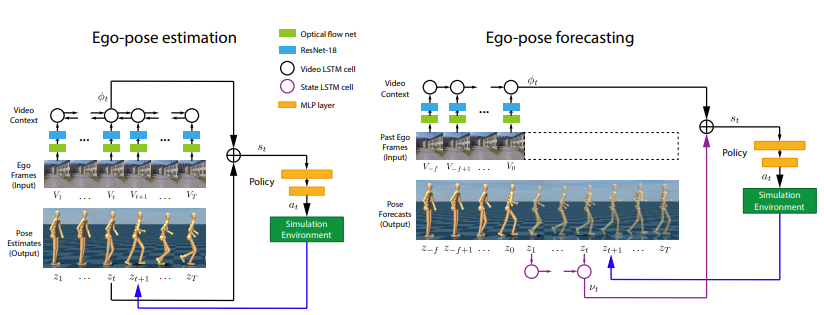

本論文は、頭に付けた1台のウェアラブルカメラからの一人称視点映像を入力に、自分の3D姿勢を推定するReinforcement Learningベース法を提案します。また動きの未来予測として、将来の動きを生成することも可能にします。本研究チームによる以前の論文では、歩行や走行などの単純な動きにおける推定を実証しました。今回は、しゃがむや曲がるなどのさらに複雑な動きを推定します。

提案手法は、一人称視点映像と様々な人間の動き(ジョギング、曲げ、うずくまり、回転、ホッピング、傾斜など)からなるモーションキャプチャデータを用いて直接学習します。Reinforcement Learningを介して学習したモデルは、複雑な人間の動きに対する正確な姿勢シーケンスを推定し物理シミュレーションを通してヒューマノイドを生成します。

本提案は、周囲に外部カメラをセットすることもなく、屋内外で推定することが可能です。本研究は多様なことに活用できます。患者のリハビリ状態を医師が遠隔でモニタリングするのに活用したり、ヴァーチャルにおける素材として活用したり、アスリートの動き強化にコーチングシステムとして活用したり、などが考えられます。