セントルイス・ワシントン大学、Adobe Research、Argo AI、サイモンフレーザー大学の研究者らは、屋内シーンにおける1枚の画像からピース単位の平面深度マップを再構築する「PlaneNet」を発表しました。

論文:PlaneNet: Piece-wise Planar Reconstruction from a Single RGB Image

著者:Chen Liu, Jimei Yang, Duygu Ceylan, Ersin Yumer, Yasutaka Furukawa

GitHub:art-programmer/PlaneNet

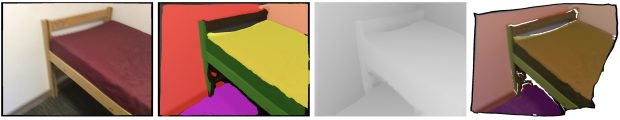

(左から順に、入力画像、ピース単位の平面セグメンテーション、再構成した深度マップ、テクスチャマッピングした3Dモデル)

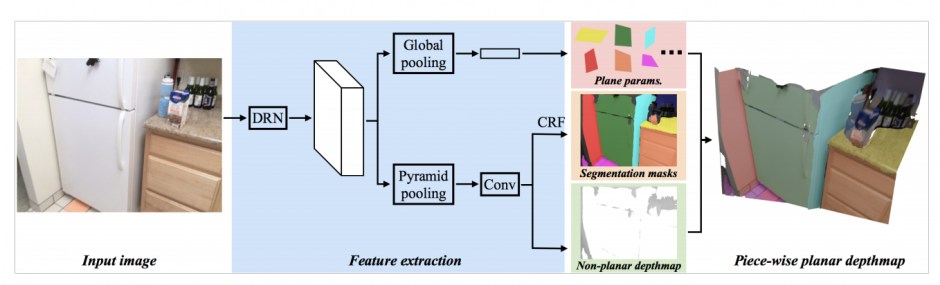

本稿は、単一のRGB画像から平面の深度マップを生成することを学ぶアーキテクチャを提案します。本提案手法は、エンド・ツー・エンドのDNN(deep neural network)を用いたアーキテクチャで、単一のRGB画像から平面パラメータセットと平面セグメンテーションマスクを推定します。

ネットワークは、DRN(Dilated Residual Networks)上に構築されており、屋内RGB-DビデオデータベースのScanNetで訓練されます。