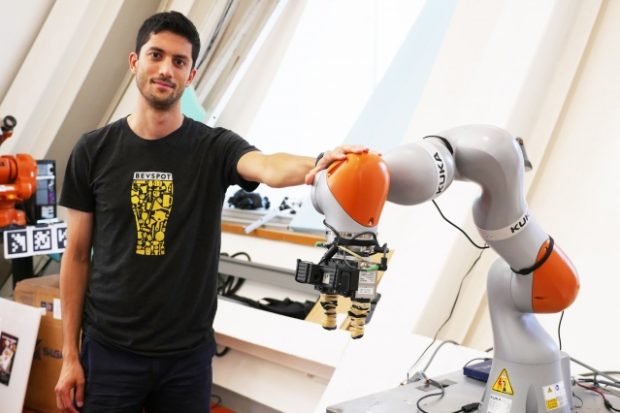

MIT CSAIL(Computer Science and Artificial Intelligence Laboratory)の研究者らは、新しい物体に対してコンピュータビジョンを用いて何を見ているかを把握し、掴んで拾い上げることができるロボットアームシステムを発表しました。

論文:Dense Object Nets: Learning Dense VisualObject Descriptors By and For Robotic Manipulation

著者:Peter R. Florence, Lucas Manuelli, Russ Tedrake

ロボットは、あらかじめプログラムされた物体を拾い上げることはうまくいきますが、新しい物体に対しては困難します。そこで、本論文では、ニューラルネットワークを用いて、ランダムな物体を視覚的に認識し把持できるロボットアームシステム「Dense Object Nets(DON)」を提案します。

ロボットは、新しい物体に対して、さまざまな角度からの目視検査後に物体のすべての点をマップして全体的な座標系であるビジュアルロードマップを生成することで、物体を把握し目的の作業を可能にします。ラベル付きデータセットで事前に訓練されておらず、人の助けなしに物体を視覚的に構築することができます。

例えば、靴をピックアップする場合、かかとの上(物体の特定の場所)を掴んで作業することを覚えると、形状や色などが異なる新しい靴を見ても、靴と認識しかかとの上をうまくつかみピックアップすることができます。

また、DONは、物体を種類(靴、マグカップ、帽子など)で分類するだけでなく、種類内の具体的な特定まで識別することが可能で、例えば、靴山の中から特定の靴をピックアップすることも可能にします。