AICFVE Beijing Film Academy、山東大学、Microsoft Research Asia、ヘブライ大学、北京大学、テルアビブ大学の研究者らは、ビデオ間の着衣する人の全身運動を転送する機械学習を用いたパフォーマンスクローニングを発表しました。

論文:Deep Video-Based Performance Cloning

著者:Kfir Aberman, Mingyi Shi, Jing Liao, Dani Lischinski, Baoquan Chen, Daniel Cohen-Or

左:模写したいビデオ内の人の動き。右:動きを転送した本システムの出力結果

本論文は、DNN(Deep Neural Network)を用いて、ビデオ内の人の動きを別のビデオ内の人の動きへ転送し再現するビデオベースのパフォーマンスクローニングを提案します。

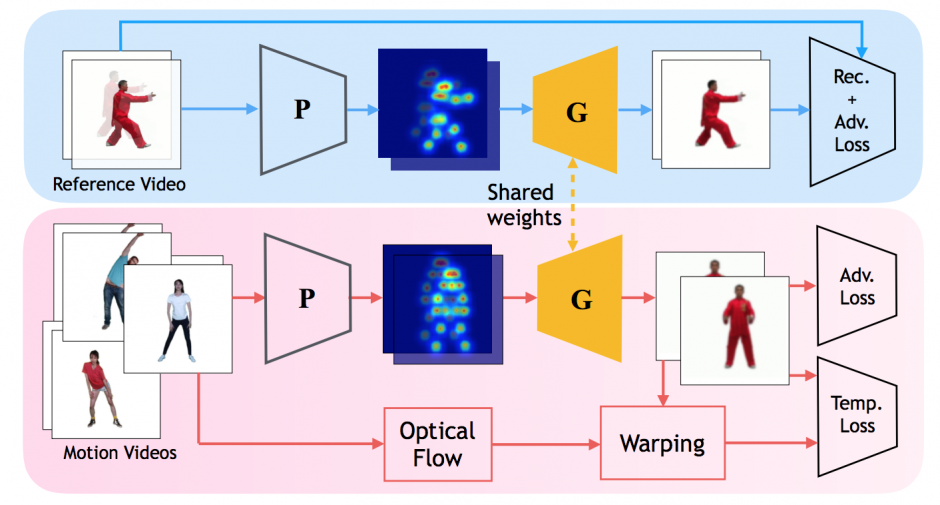

本提案手法は、2種類のブランチから構成されており、1つ目は参照ビデオから抽出されたペアのトレーニングデータから、2つ目は1つまたは複数の追加のビデオから抽出されたペアでないデータから、これらを用いて訓練します。

生成されたフレームは、参照ビデオのネットワークに適応し、パッチビデオとして参照ビデオに存在するポーズの断片をつなぎ合わせることによって、ターゲット個人の新たなポーズを生成することで所望の動作を再現することを可能にします。

制限としては、大人のパフォーマンスを子供に、またはその逆にすることは不可能などがあります。以下の動画から出力結果を確認することができます。