ユニヴァーシティ・カレッジ・ロンドン(UCL)、フランス国立情報学自動制御研究所(INRIA)、ニース・ソフィア・アンティポリス大学、ノースカロライナ大学チャペルヒル校、Nianticの研究者らは、より臨場感のある実写ベースの写実的な仮想空間内を作成できるCNN(Convolutional neural network)を用いた自由視点レンダリング法を発表しました。

論文:Deep Blending for Free-Viewpoint Image-Based Rendering

著者:Peter Hedman, Julien Philip, True Price, Jan-Michael Frahm, George Drettakis, Gabriel Brostow

左が本提案手法の出力結果

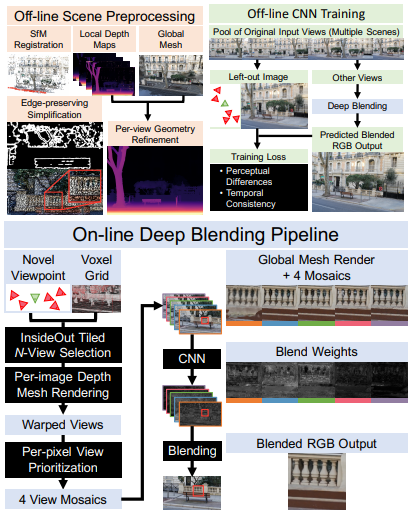

本論文は、インタラクティブに自由視点移動が可能な実写ベースの仮想空間をモデリングするCNNを用いた手法を提案します。

本提案手法は、実写画像から新規のビューを合成するレンダリング法「Image-based rendering(IBR)」を用いて行います。IBRは、現実的な品質を描画できますが、多くのアーティファクトに悩まされているのが現状です。そこで、本提案手法では、IBRのコア部分であるブレンドステップに、deep learningを用いるアプローチでアーティファクトを軽減させます。

具体的には、関連する入力画像を結合するためにブレンドウェイトを計算することを学習します。トレーニングデータは、19種類のシーンからの2630枚の入力写真のデータセットを活用します。そして、予測されたブレンドウェイトを用いて新規ビューを合成することで、より写実的なレンダリングを可能にします。これにより、IBRにおいて、従来の方法と比較してもアーティファクトを大幅に削減することを実証しました。