東京大学の研究チームは、漫画内のキャラクタの顔分類を行う機械学習を用いたクラスタリング法を発表しました。

論文:Character Representation Adaption in Individual Manga

著者:Koki Tsubota, Toru Ogawa, Toshihiko Yamasaki,Kiyoharu Aizawa

所属:The University of Tokyo

本論文は、漫画内のキャラクタに対して、クラスタリングすることでキャラクタの顔分類を行う手法を提案します。前提として、漫画におけるコマと顔のバウンディングボックスを検出しているものとします。(したがって、本提案の精度はバウンティングボックスの検出精度に比例します。)

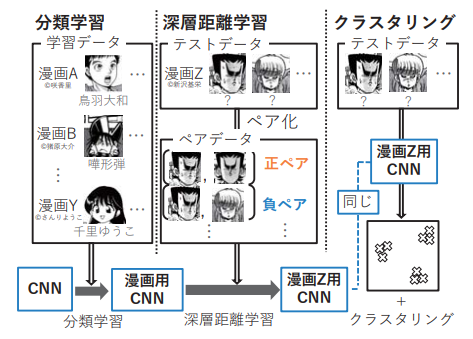

本提案手法は、漫画内のキャラクタに適応した特徴抽出器を作成するために、最初に教師あり学習によって漫画に汎用性のある特徴抽出器を作成し、その後深層距離学習により漫画内のキャラクタに適応した特徴抽出器を作成、最後に、その特徴抽出器から得られる特徴量に対してK-meansを適用することで分類を行います。

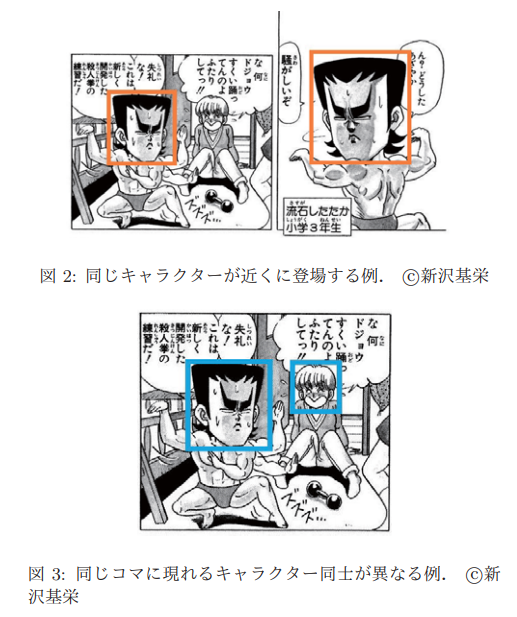

本提案の深層距離学習を行うには、顔画像と名前のペアが与えられないという状況で、正ペア/負ペアを作成する必要があります。作成は、その顔画像が登場するページと前後一ページの顔画像の中で最も特徴量が近い顔画像を正ペアとし、同一のコマに登場する全ての顔画像を負ペアとして決定します。これらは、同じキャラクタは近くのコマやページに登場する傾向、同じコマには同じキャラクタがほぼ登場しない傾向という漫画特有の性質から導きました。

結果、この漫画特有の正ペア/負ペアを導入した深層距離学習による特徴量の作成からのクラスタリングを行うことで、深層距離学習を行わない場合と比較してより良い精度を報告しました。

これにより、漫画のキャラクタの顔分類がより良い精度で推定でき、顔画像を名前と対応させることでキャラクタ名で検索したり、吹き出しと対応させることで話者同定ができたり、キャラクタを区別することで着色等一貫した処理ができたり、といった応用に活用することが可能となります。