UCLA Samueli School of Engineeringなどによる研究チームは、断片画像のみからオブジェクトの全体像を識別するコンピュータビジョンシステムを発表しました。

論文:Brain-inspired automated visual object discovery and detection

著者:Lichao Chen, Sudhir Singh, Thomas Kailath, Vwani Roychowdhury

所属:UCLA Samueli School of Engineering, Stanford

オートバイの断片画像だけに基づいて、オブジェクトを識別することができる

本論文は、断片画像のみから物体の全体像を生成する手法を提案します。人間は、例えば椅子の後ろに隠れた犬の足としっぽのみを見ただけで、犬という全体像を思い浮かぶことが出来ます。本研究は、このような能力を備えたコンピュータシステムを構築することを目指します。

そして、現在のコンピュータビジョンシステムは、自分自身で学ぶようには設計されていませんし、画像内のオブジェクトが何を表しているのかを判断するための理論的根拠を説明することもできません。本研究は、これら欠点を解決するアプローチでもあります。

オートバイの断片画像

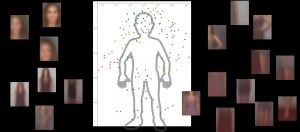

本提案手法は、大きく3つのステップで構成されます。最初に、システムは”viewlets”と呼ぶ方法で画像を小さな塊に分割し、これらがどのように組み合わされて対象のオブジェクトを形成するかを学習します。そして最後に、周囲に他のオブジェクトがある場合、それらが対象オブジェクトの記述と識別に関連しているかを調べます。

この学習法は、オブジェクトに対して、一部が隠蔽された画像や鳥瞰画像、接写画像など、さまざまな観点、そしてさまざまな環境に置かれていることを考慮します。それは、人間が生まれてから物体を学ぶ上での環境に類似しており、対象のオブジェクトを多くのコンテキストで何度も見て何が何であるかを学んでいること、このコンテキスト学習を目指しています。

人の何千もの画像を見ることによって人体が何であるかを理解します。不要な背景は無視します。

これらのことで、今までのコンピュータビジョンシステムのように、手動でラベル付けされたデータセットを用いるのではなく、オブジェクトの自動分離と新しいシーンでの効率的な検出、位置特定のための教師なし学習フレームワークを開発する、それはマシン自身で学習し、直感的に理解し、推論に基づいて決定を下す、より人間的な方法で人間と対話するコンピュータへの重要なステップになるとしています。