南カリフォルニア大学とミネソタ大学の研究チームは、RGB-Dカメラを用いて、実物体の反射特性や照明条件を推定し写実的な仮想オブジェクトをリアルタイムに生成する手法を発表しました。

論文:Automatic Generation of Dynamically Relightable Virtual Objects with Consumer-Grade Depth Cameras

著者:Chih-Fan Chen, Evan Suma Rosenberg

所属:University of Southern California, University of Minnesota

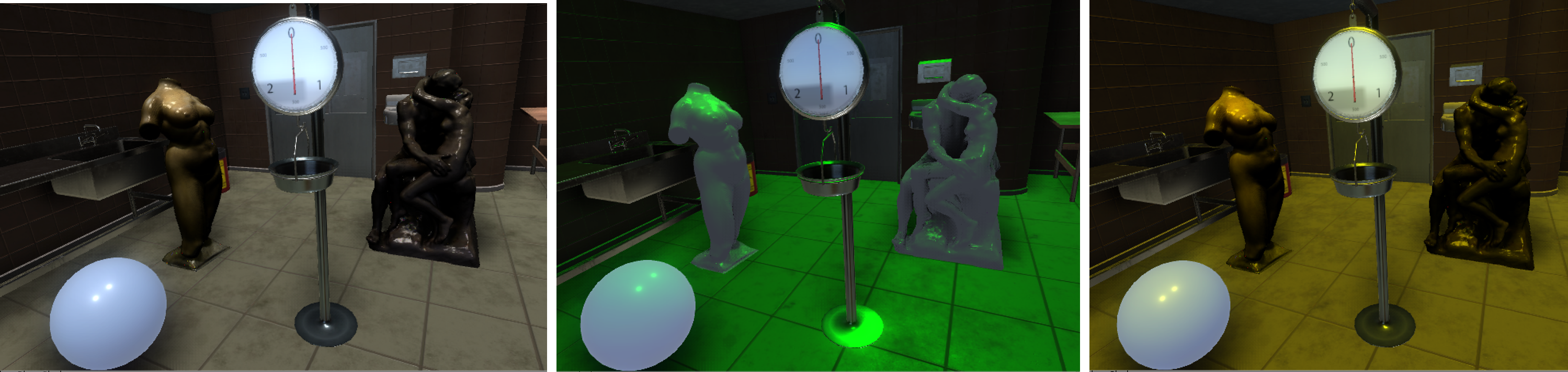

本論文は、コンシューマレベルのRGB-Dカメラを使用して、捉えた物体の照明と反射率の特性を推定し写実的なオブジェクトをリアルタイムに生成するためのアプローチを提案します。本提案手法は、RGB-Dカメラで取得したデータから、拡散反射率と鏡面反射率、キャプチャ中の照明条件を推定し、フォトリアリスティックな外観を再現する完全自動のパイプラインを実装します。

パイプラインでは、RGB-Dで捉えたデータからジオメトリの構築、拡散成分と鏡面反射成分への分離、そして照明条件および仮想オブジェクトの反射率特性を推定します。これら照明条件と鏡面反射率、拡散テクスチャを組み合わせることで、キャプチャしたオブジェクトの外観を任意の視点から合成することができます。

これら再構築した照明条件は、ユーザの視点に基づいて動的に変化し、また、ハンドヘルドコントローラを使用して、仮想の光の強度、方向、色を直接操作することも可能です。さらに、キャプチャしていない目に見えない視点に対しても、もっともらしい出力結果を生み出すこともします。