マサチューセッツ・ボストン大学などによる研究チームは、360°パノラマ画像の各オブジェクトに適した音を配置する空間オーディオ・アルゴリズム「Audible Panorama」を発表しました。

論文:Audible Panorama: Automatic Spatial Audio Generation for Panorama Imagery

著者:Haikun Huang, Michael S. Solah, Dingzeyu Li, Lap-Fai Yu

所属:University of Massachusetts, Boston, Adobe Research, Columbia University, George Mason University

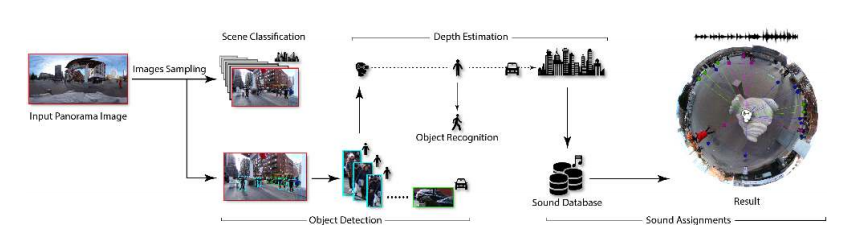

本論文は、オーディオを360°パノラマ画像シーンに適した音源に割り当てるアルゴリズムを提案します。本提案手法は、画像内のシーンとオブジェクトを識別し、各オブジェクトの奥行きを推定、現実的なオーディオソースを希望の位置に配置することで臨場感を高めるアプローチです。

本アルゴリズムは、オブジェクト検出、シーン分類、オブジェクト深度推定、およびオーディオソースの配置を行うことで実行します。具体的には、パノラマ画像を入力に、シーンの分類、オブジェクトの検出、およびアクション認識の後、画像にバックグラウンドタグとしてラベル付けした画像を表示します。そして、推定した各オブジェクト位置に適切な音源を割り当てます。

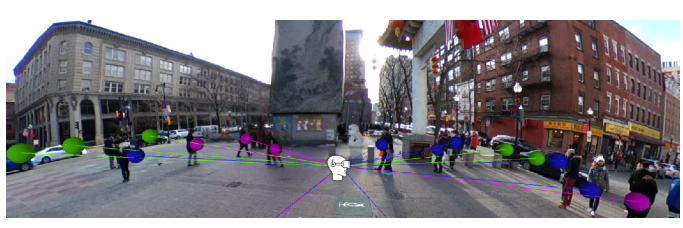

下図のように、緑は車の音、紫は歩いている人、青は雑談している人といった具合に、それぞれの音源を深度含めた各位置に割り当てます。

このプロセスを容易にするために、500を超える屋内外シーンの音源ファイルで構成されるオーディオファイルデータベースを構築しました。これらのファイルは、バックグラウンドファイルとオブジェクトオーディオファイルの2種類に分類されます。

オブジェクトの深度推定には、最初のオブジェクトをベースラインに、画像上で検出された2つの物体を比較することで測定し、また、実世界のデータから取得した人間の身長などの平均値に基づいて行います。これらのことにより、VRで360°画像を閲覧したときの臨場感をより向上することを実現します。