カリフォルニア大学バークレー校とGoogleの研究者らは、ステレオカメラ、VRカメラ、iPhone 7/Xなどのデュアルレンズカメラで撮影した画像から奥行き感がある現実的なビューを作成できる、機械学習を用いたシステムを発表しました。

論文:Stereo Magnification: Learning view synthesis using multiplane images

著者:Tinghui Zhou,Richard Tucker,John Flynn,Graham Fyffe,Noah Snavely

本稿は、ステレオ画像ペアから奥行き感がある新たなビューを作成するエンドツーエンドのDeep learningフレームワークを提案します。

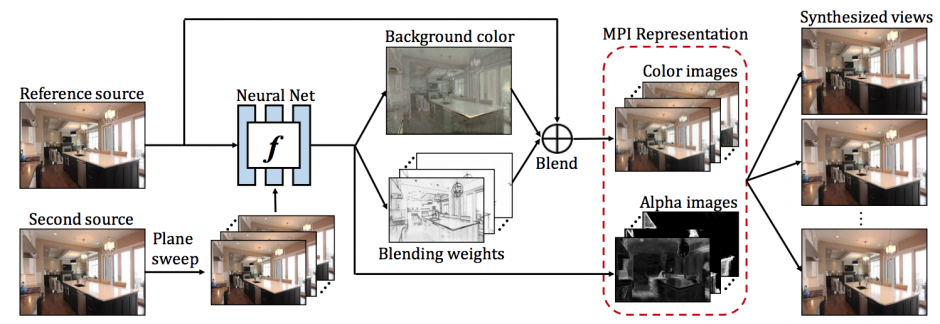

本提案手法は、ステレオ画像ペアを入力に、Fully-convolutional network(FCN)を用いて、「Multiplane images (MPI)」と呼ぶレイヤ表現を推定、推定したMPIを使用して合成し新規ビューを生成します。

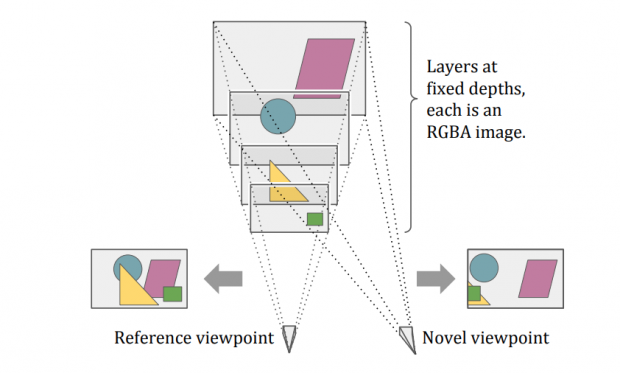

MPIは、奥行きを表現するマルチプレーン・カメラを思い出すような仕組みで、異なる深度にある複数の層で構成されており、入力ビューを超えて外挿します。このMPIを用いて、新規ビューの現実的なレンダリングを可能にします。

(MPIの概要図)

データセットは、Youtubeからの長さ1〜10秒のビデオクリップ、とりわけ好条件の不動産ビデオ含む7,000以上を使用し訓練しました。

これらのことで、ステレオカメラからの画像を用いて、奥行き感がある新たなビューを生成することを可能にします。

本アプローチは、屋内と屋外の両方のシーンに対応しており、また、本稿はステレオ入力に焦点を当てていますが、単一または複数の入力ビューを備えたビュー合成設定に適合させることもできるとしています。さらに、MPIからのビューのレンダリングは非常に効率的であり、リアルタイムアプリケーションの可能性もあると述べます。