GoogleとOpenAIによる研究チームは、画像が提供されたときに、ニューラルネットワークがどのように画像分類するかを可視化するアプローチ「Activation Atlases」を発表しました。

論文:Exploring Neural Networks with Activation Atlases

著者:Shan Carter, Zan Armstrong, Ludwig Schubert,Ian Johnson, Chris Olah

所属:Google Brain Team, Google Accelerated Science, OpenAI, Google Cloud

本論文は、画像分類ニューラルネットワークの意思決定プロセスを視覚化するアプローチを提案します。

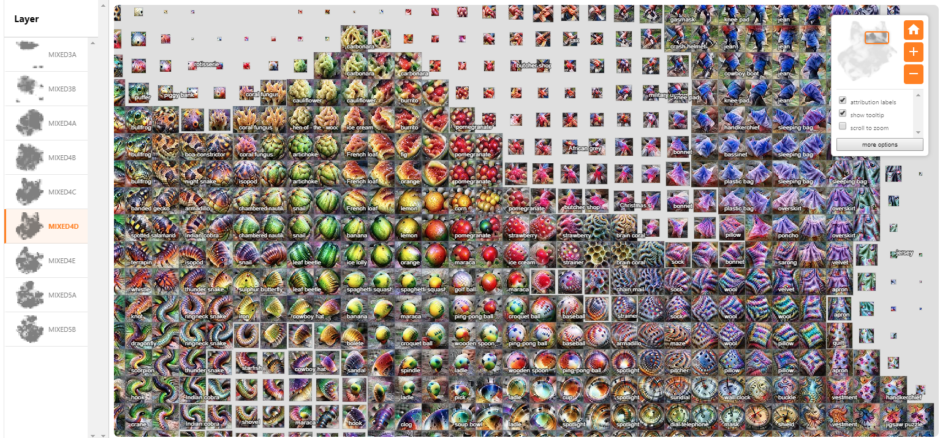

本提案を実証するために、画像データセット「ImageNet」で訓練された画像分類ネットワークInceptionV1(GoogLeNet)を用いて構築します。ネットワークは、約10層を通して画像データを段階的に評価します。下図のように、分類途中の画像の集合体がWebページ上に表示され、それが層の数だけビジュアライズされます。

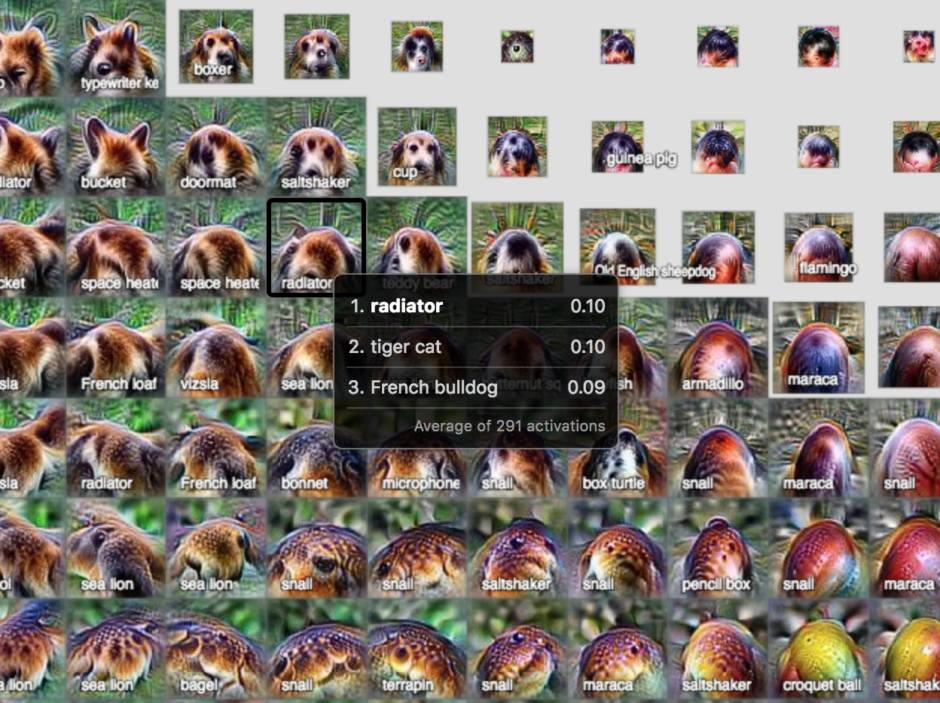

拡大や縮小も自由にでき、個々の画像にカーソルを合わせると、3つの特徴の比率も表示されます。人が見ても理解できるように作られています。

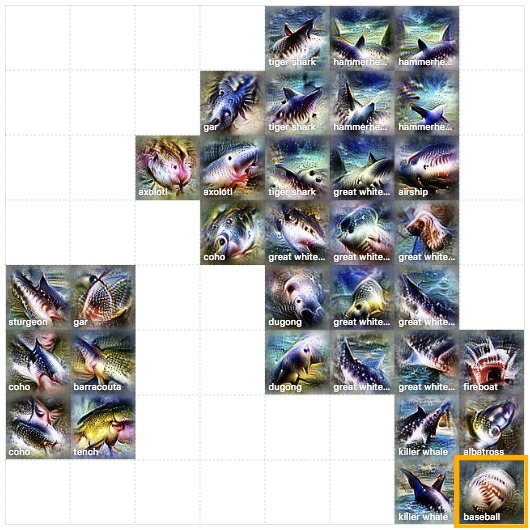

これらのことにより、ニューラルネットワーク内で何が起こっているのかをより理解できるのと同時に、ネットワークが誤った相関に頼って画像を分類したりなど、誤った分類をする要因を局所的に発見し修正することも可能です。例えば、以下の画像のように、サメっぽい画像の中に1枚だけ野球ボールっぽい画像が紛れているなど、明らかに違うことを発見することができるといった具合です。