MPI-Inf、SIC、Google、スタンフォード大学による研究チームは、2種類の顔画像から任意の照明下で動的被写体を照らすことができるdeep learningとLightStageを用いた手法を発表しました。

著者:Abhimitra Meka, Christian Haene, Rohit Pandey, Michael Zollhöfer, Sean Fanello, Graham Fyffe, Adarsh Kowdle, Xueming Yu, Jay Busch, Jason Dourgarian, Peter Denny, Sofien Bouaziz, Peter Lincoln, Matt WhalenGeoff Harvey, Jonathan Taylor, Shahram Izadi, Andrea Tagliasacchi, Paul Debevec, Christian Theobalt, Julien Valentin, Christoph Rhemann

所属:Max Planck Institute for Informatics, Saarland Informatics Campus, Google,Stanford University

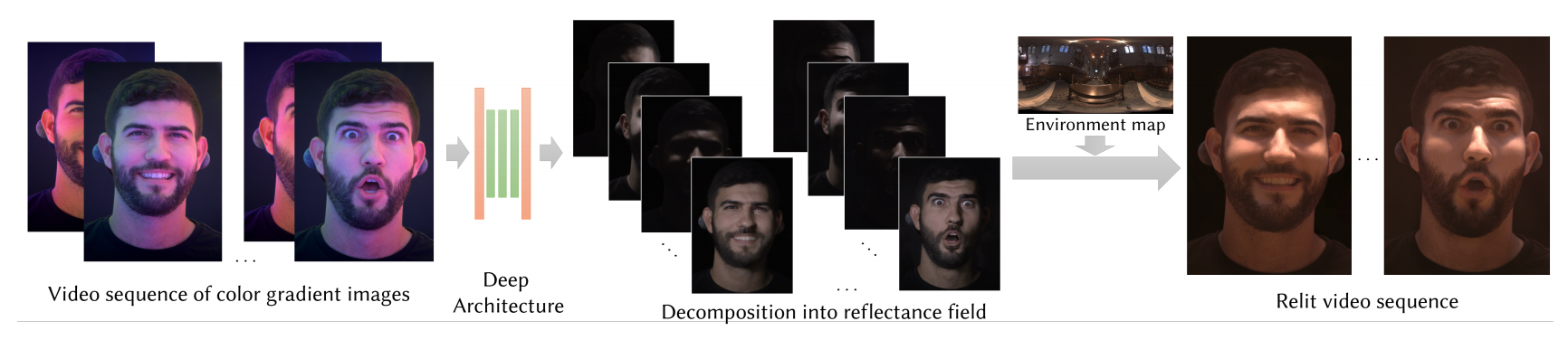

顔画像の照明を後から修正し写実的に描画することは、ヴァーチャルリアリティなどにおいて多くの視覚効果をもたらします。しかしながら、顔領域は目や歯などパーツが多いのに加えて、鏡面反射や表面下散乱など複雑で困難なのが現状です。そこで本論文は、顔反射率のモデルを学習することにより、人間の顔の照明を推定しより高品質に描画する画像ベースのリライティング技術を提案します。

2種類の画像とライティング方向を入力に、U-Netアーキテクチャを介して推定する

提案手法は、LightStageでキャプチャした顔画像からネットワークを学習します。LightStageとは、全方位に331個の照明と複数カメラで構成された直径3.5mの球形ドーム型キャプチャシステムです。大量の照明を制御しながら顔の形状や質感を高品質に取得できます。

そんなLightStageを用いて30fpsで顔をキャプチャし、画像から推定するためのdeep learningモデルを学習します。これにより球面照明下で撮影した2種類の顔画像とライティング方向を入力に、指定した照明条件の推定と再構築を可能にします。