北京理工大学とジョージ・メイソン大学の研究チームは、シーンに合わせてARにおける仮想キャラクタの位置と向きを最適化するCNNを用いた手法を発表しました。

論文:Virtual Agent Positioning Driven by Scene Semantics in Mixed Reality

著者:Yining Lang, Wei Liang, Lap-Fai Yu

所属:Beijing Institute of Technology, George Mason University

本論文は、光学シースルーHMD(本論文ではHoloLensを採用)において、仮想キャラクタを配置する際に実世界のシーンの意図を考慮して配置するCNN(Convolutional Neural Network)を用いたアプローチを提案します。提案手法を進めるには、シーン内にどんな種類のオブジェクトがあるのか、オブジェクトがどこにあるのか、そしてユーザがどこにいるのかを把握する必要があります。

本提案手法は、HoloLensに搭載されたRGB-Dカメラを使用することによってシーンの3Dモデルを再構築し、物体検出やセグメンテーションができるMask R-CNNを使用して、シーンコンテキスト内のインタラクションに関連するオブジェクトを検出します。

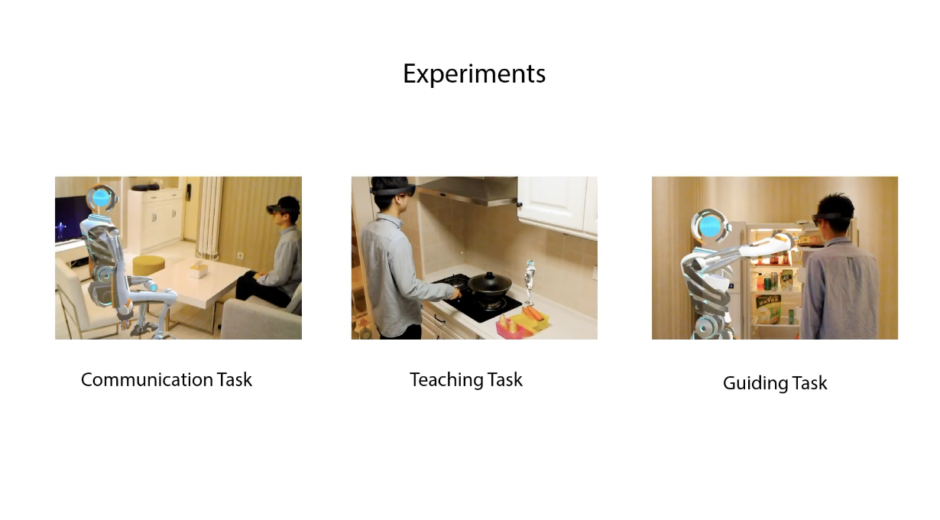

最後に、最適化プロセスを通して、シーンの意味および対話の目的に従って仮想キャラクタを配置し視覚化するための適切な位置および向きを決定します。これにより、ARシーンに合わせて仮想キャラクタが適切に配置され、ユーザがより現実的に仮想キャラクタと対話することを可能にします。