東京大学大学院とJST さきがけによる研究チームは、人の触れている対象の硬さ柔らかさを映像ベースで推定するConvolutional Neural Network(CNN)を用いた手法を発表しました。

論文:Softness Estimation Based on Images of Pushing Action Using Deep Learning

著者:Yuri Mikawa, Yasutoshi Makino, Hiroyuki Shinoda

所属:The University of Tokyo, JST PRESTO

本論文は、人の触動作を計測し、人の触れている対象の触覚情報を映像ベースで推定する手法を提案します。専用の計測器を必要とせず、特殊なセンサを直接接触させることなく、対象に触れた際の手腕の動作映像を元に、CNNを利用して対象の硬さを推定します。

本提案は、テレビでの食事レポートの際に、対象表面を押下してその柔らかさを伝えることに着想を得たものです。それで柔らかさを伝えられるのであれば、その映像の中に対象の触覚情報を推定する情報が含まれているだろうということで、まずは触覚情報を映像ベースで推定する初期ステップとして、弾性体を箸で押下した際、手腕の動作や箸の挙動にどの程度対象の硬さ情報が含まれているのか、またそれを映像からどの程度の精度で推定できるのかを検証します。

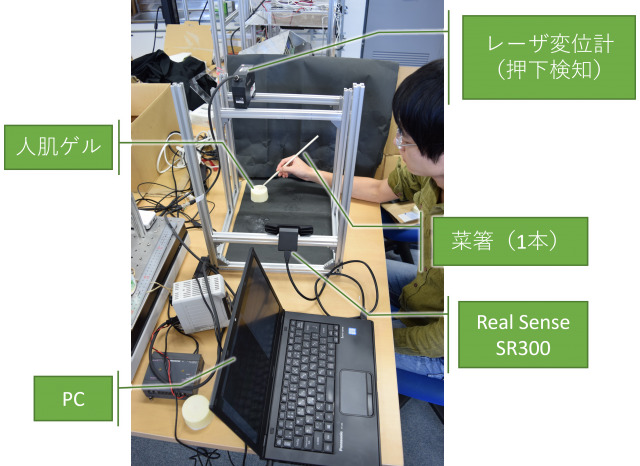

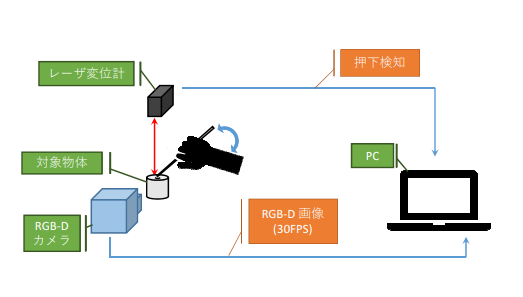

実験では、人肌のゲル (EXSEAL Co., Ltd.) で作成した柔らかさの異なるサンプルを対象物とし、それを箸で押下している際の手腕動作を計測するシステムを設計します。具体的には、押している様子をRGBカメラと深度カメラ(Real Sense SR300)により計測し、押下対象表面の変位をレーザ変位計により計測することで、押下時の手腕と箸の動作画像を自動的に生成、CNNにより対象の硬さを推定します。正解となる硬さはデュロメータで計測します。

柔らかさの異なる押下対象物体のサンプルの一部。人肌のゲル (EXSEAL Co., Ltd.) で作成

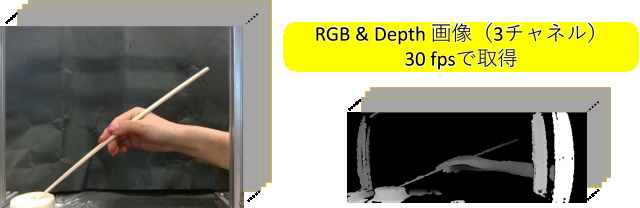

取得される画像。左はRGB、右はDepth画像

押下動作映像を取得するためのシステム、ないし被験者による押下状態計測の様子

押下動作映像を取得するためのシステム

結果、一般的な硬さセンサの代替として利用できるほどの精度には至っていないものの、映像ベースで高精度に硬さ予測ができることを実証しました。また、この実証は、VR体験における映像に対して、専用の計測器を用いることなく触覚を付与したりなど、多様な応用に発展できる可能性も示しました。

今後の展望としては、押下検出をビジョンベースで行いデバイスレス化を目指すことや、より広い範囲の硬さ推定、より制約のない押下方法への対応、未知の被験者にも適用可能な学習モデルの構築、人間と学習器との弁別精度の違いの評価、高速化に努めリアルタイム予測の実現を目指すことなどを挙げています。将来的には、加熱中の肉の硬さ変化などをスマホのカメラで推定し、好みの焼き加減で火を止められるようにするなど、センサを直接触れたくないような環境下での利用を目指しています。