清華大学、北京航空航天大学、Google、南カリフォルニア大学、マックス・プランク情報科学研究所、BNRistの研究者らは、1台の深度センサから、人の形状と動きをリアルタイムに再構築するコンピュータビジョンシステム「DoubleFusion」を発表しました。

論文:DoubleFusion: Real-time Capture of Human Performances with Inner Body Shapes from a Single Depth Sensor

著者:Tao Yu, Zerong Zheng, Kaiwen Guo, Jianhui Zhao, Qionghai Dai, Hao Li, Gerard Pons-Moll, Yebin Liu

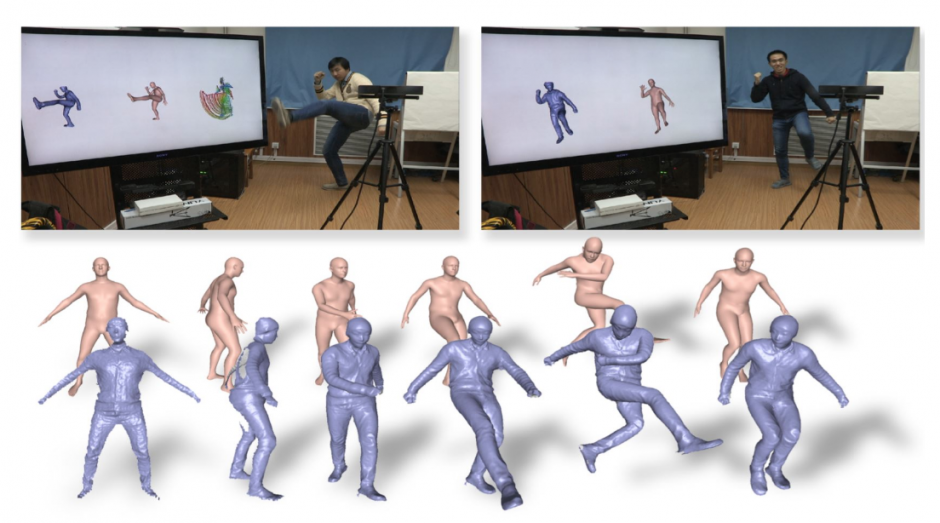

本稿は、1台の深度センサから人の内面の形状と姿勢、外面の形状と動きをリアルタイムで同時に再構築するシステムを提案します。

本提案手法は、従来の方法である「DynamicFusion」と「BodyFusion」に基づいており、奥行きデータを使用した姿勢推定と、骨格から推定した姿勢推定を組み合わせて精度を高めています。

これらのことで、深度センサの1視点からの入力で、服の下の身体形状や位置などを捉え、衣服や髪の毛を含めた外側の形状、そしてその動きを(ダンスのような素早い動きでも)リアルタイムに再現することを可能にします。

制限としては、厚手の服や布面積が多い衣服などは正確に再現することができず、また、人とオブジェクトのやり取りを正確に再構築することはできません。これらは、今後の課題としています。