米ノースカロライナ大学チャペルヒル校とAdobe Researchの研究者らは、機械学習アルゴリズムを訓練して、短いビデオクリップ用の現実的なサウンドトラックを生成する手法「Visual to Sound」を論文にて発表しました。

Visual to Sound: Generating Natural Sound for Videos in the Wild

チームは、GoogleのAudioSetの大規模なラベル付きデータセットを使用しました。そして、オフスクリーンの音源は排除したいので、AmazonのMechanical Turkを使用してこれらをフィルタリングします。

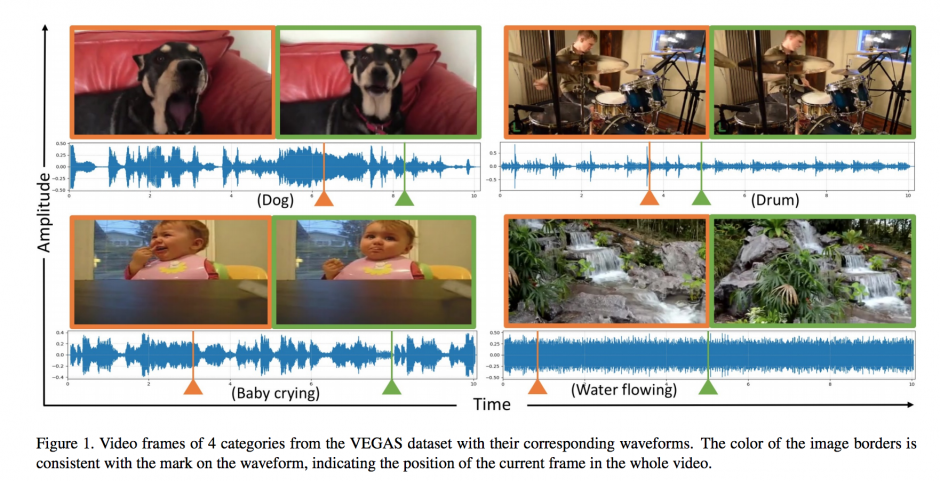

これにより、長さが約7秒で、10種類のカテゴリをカバーする28,000以上の新しいデータセットが作成されました。次に、これらのデータセットを使用して、各カテゴリに関連付けられた波形を認識し、SampleRNNというニューラルネットワークを使用してゼロから再現するようにマシンを訓練。

最後に、人間の評価者にビデオに付随する音質を評価し、それが実際のものか人工的に生成されたものかを判断することによって結果をテストし生成しました。

また、これら生成した音はミックスすることもでき、例えば、川で遊ぶ犬の場合、川の音と犬の鳴き声を同時に出力することも可能です。

生成された音の性能は、以下の映像から、どちらがリアルな音なのか、どちらがマシンが生成した音なのかのテストで確認できます。

関連

Disney Research等、音声データからそれに合わせた顔面アニメーションを生成するDeep Learningアプローチを論文にて公開 | Seamless