国立交通大学の研究チームが開発した「Adversarial Colorization Of Icons Based On Structure And Color Conditions」は、手書きのスケッチをフラットカラーイラストに変換するGAN(Generative Adversarial Network)を用いた手法だ。ユーザーが描いた輪郭画像を入力としてネットワークが受け取り、カラー化されたアイコン画像を出力する。

線画から着色する同様のアイデアは、キャラクターのカラー化にも採用されており、User-Guided Deep Anime Line Art Colorization with Conditional Adversarial Networks [Ci et al. 2018] などで実証されている。

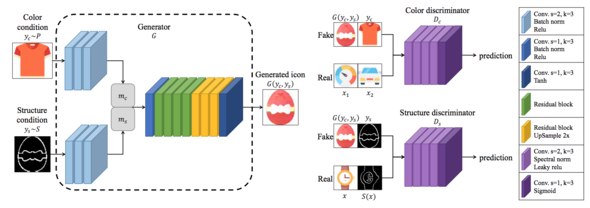

今回提案するGANアーキテクチャは、生成器と識別器を1対1で敵対させる方式ではなく、生成器と2種類の識別器を敵対させて、それぞれの画像が構造的に似ているか、色調が似ているかを判断する「dual conditional GAN」を用いる。

ネットワークの入力は、解像度64×64×3の等高線画像と参照アイコン画像であり、前者は構造、後者は色条件である。これらを結合し生成器で偽のアイコンを作成、輪郭識別器と色識別器の2つのサブタスクに分離し送り学習する。2つの識別器は、ペアになった画像の構造と色がよく一致しているかどうかを判断する

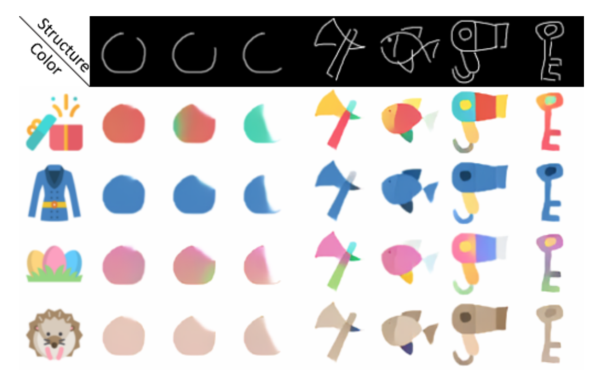

学習したモデルは、下図で確認できるように、手書きの輪郭構造とアイコンの色合いが統合されたフラットカラーイラストを生成する。

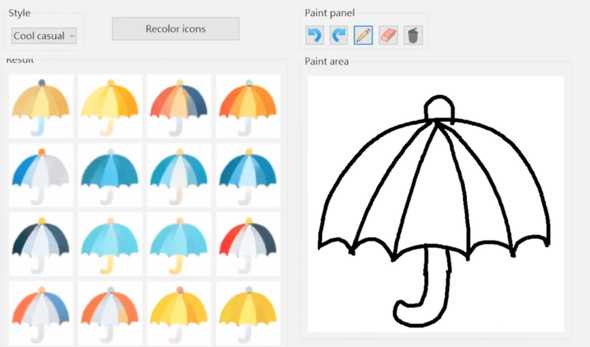

GPUリソースを活用すると、リアルタイムにアイコンを着色できるため、ストロークが更新されるたびに輪郭画像と参照アイコンをネットワークに供給し、生成された結果を直ぐに表示可能である。

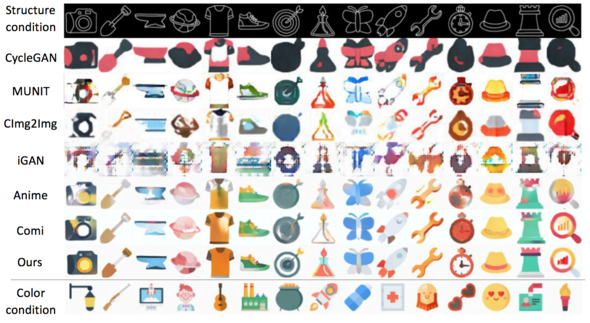

下図のように、CycleGAN、MUNIT、CImg2Img、iGAN、Anime、Comiのような類似研究と出力結果を比べても、一番もっともらしいフラットカラーイラストを出力しているのが確認できる。