チェコ工科大学とSnapによる研究チームは、ある画風スタイルを画像に転送する深層学習を用いたスタイル変換技術「Interactive Video Stylization Using Few-Shot Patch-Based Training」を発表した。スタイル変換とは、手書き風のスタイルを画像や動画に転送し、コンテンツの原型は残しつつスタイルだけを変換する技術だ。

こういったスタイル変換分野では、画像へ転送する技術として2016年に「Image Style Transfer Using Convolutional Neural Networks」[Gatys et al. 2016]で発表されている。CNNを用いたVGGを使用し、コンテンツとスタイルの分離を行い、コンテンツを保ったままスタイルを別のものと入れ替えるアプローチ。

その後、スタイル変換を動画(映像シーケンス)に適応した技術も多数登場しました。Content and Style Disentanglement for Artistic Style Transfer [Kotovenko et al.2019]、Artistic style transfer for videos and spherical images [Ruder et al.2018]、A StyleAware Content Loss for Real-Time HD Style Transfer [Sanakoyeu et al.2018]。

動画でも重要な箇所は画像のコンテンツとスタイルを上手く分離できるような損失関数を求めること。例えば、Stylizing Video by Example [Jamriška et al. 2019]では、動画の1キーフレームを変えることで他のシーケンス(動画全体)に伝達していく仕組みを採用している。パッチベースで行うことで高品質な結果を出力した。

しかしながら、これらの変換は映像を連続的にしかスタイリングできないため、ランダムアクセス、並列処理、ユーザーが描くスタイルを即座にコンテンツに転送していくリアルタイムなインタラクションに対応していない。

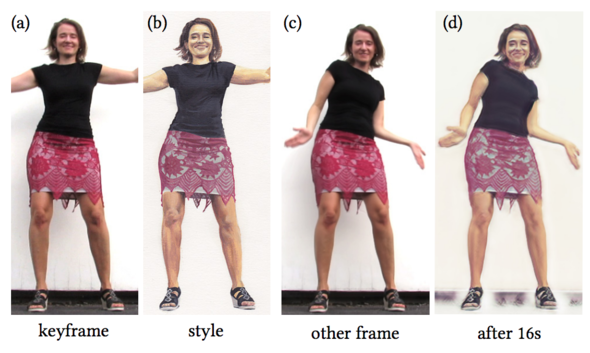

今回紹介する研究では、スタイル変換をインタラクティブに行えるようにした。先ほどと同じくキーフレームベースのスタイル変換を採用しており、1つまたは複数枚の手描きキーフレームを用いて、ターゲットシーケンス全体のスタイル化を深層学習を用いて行う。

これまでの手法とは対照的に、長時間の事前学習や大規模な訓練データセットを必要せず、この1キーフレームへのスタイリングがネットワークを訓練するための唯一のデータとしている。

映像内の任意のフレームをキーフレームとして活用し、その上からアクリル絵の具で塗っていくと、映像のキーフレーム以外も塗ったスタイルが反映されていく。16秒ほどで映像全体をスタイリング。

また、ターゲット動画をライブカメラの映像に置き換えることで、ライブ中に絵を塗ってライブシーンをスタイリングするという、これまでにないシナリオも実現した。例えば、ユーザーの顔にカメラを向けると、ユーザーはキーフレームを描くと同時に、自分のポートレートのようなスタイル化された映像を見ることができる。