テキサス大学オースティン校や中国科学技術大学などの研究者らは、視覚障害者のために、画像と画像に関する質問に正しい回答をするVQAデータセットを発表しました。

論文:VizWiz Grand Challenge: Answering Visual Questions from Blind People

著者:Danna Gurari, Qing Li, Abigale J. Stangl, Anhong Guo, Chi Lin, Kristen Grauman, Jiebo Luo, Jeffrey P. Bigham

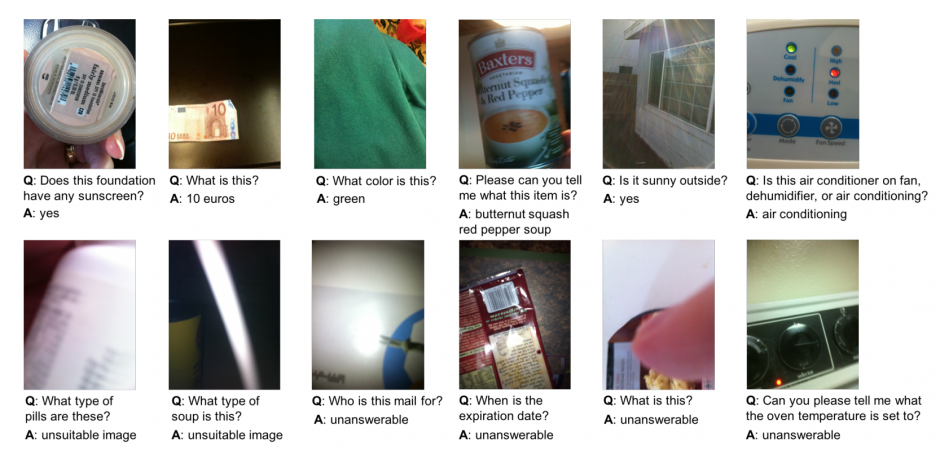

VQA(Visual Question Answering)とは、画像とその画像に対する質問文と答えのセットから正しい答えを導きだすモデルを構築するためのデータセットです。今回の発表は、VQAを視覚障害者向けに最適化したものになります。

画像と質問は、視覚障害者によって撮影/質問されました。総数は31,000以上。このセットをベースに、クラウドソーシングで回答を集めデータセットを作成します。

このことで、視覚障害者が撮影しているため画像の品質は低いですが、本当に知りたい環境で何が知りたいかを捉えているので適切な回答を提示することができ、視覚障害者が周りを認識する助けになるとしています。

関連

Microsoft Researchら、視覚障害者向けにVR空間で白杖トレーニングができる触覚杖コントローラを発表 | Seamless