Qosmoと東京大学の研究者らは、Googleストリートビューで映し出される風景に合った擬似環境音を再生する機械学習を用いた提案を論文にて発表しました。

Imaginary Soundscape : Cross-Modal Approach to Generate Pseudo Sound Environments

著者:Yuma Kajihara、Shoya Dozono、Nao Tokui

Webサイト:Imaginary Soundscape(執筆現在:PCのChromeとFirefoxに対応)

(ブラウザ上で体験している様子。ここでは水の音と風の音が再生された。)

本稿は、Googleストリートビューの画像から音と画像の間(Cross-modalモデル)の特徴を抽出し、その画像から機械学習を用いて環境音を推定するシステムを提案します。

このことで、ユーザはGoogleストリートビューを歩き回りながら、音の風景という概念「サウンドスケープ」を体験することができます。

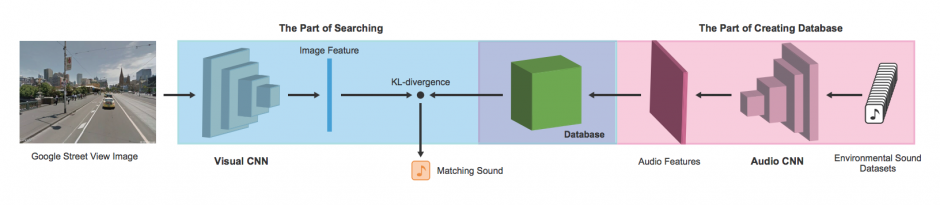

本研究では、画像と音の間の特徴を抽出するために、MITが発表した「SoundNet」に基づくCNN(Convolutional Neural Network)をベースにします。 画像から音と画像の間の特徴を抽出し、抽出した特徴と一致する最良のサウンドファイルを検索するという2ステップで構成されます。

(提案手法の概要図)

そして、Webブラウザ上で動作させるため、kerasで学習したモデルをJavaScriptベースの「webdnn」に変換します。現在、本提案手法を用いて作られたWebブラウザベースのImaginary Soundscapeをこちらから体験することができます。執筆現在、PCのChromeとFirefoxに対応しています。

また、本研究の背景などはこちらの記事をご参照ください。

関連

Adobe Researchら、機械学習を用いてリアル音と見分けがつかない短い動画用の音を生成する手法を論文にて発表。どちらが現実音かマシン生成音かをテストする動画あり | Seamless