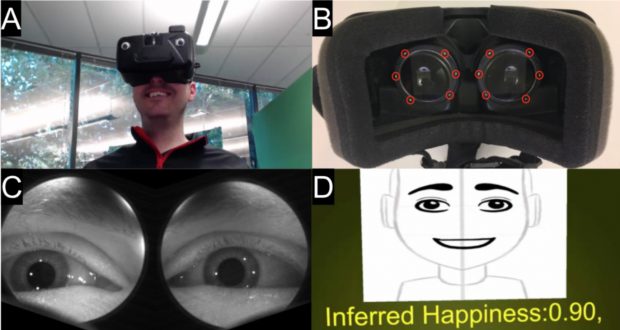

Google Researchは、VRヘッドセットを装着したユーザーの眼を追跡し捉えた画像のみで、そこから顔全体の表情をDeep learningを用いて推測する手法「Eyemotion」を論文にて発表しました。

Eyemotion: Classifying facial expressions in VR using eye-tracking cameras(PDF)

「Eyemotion」は、VRヘッドセット内の赤外線(IR)視線追跡カメラから捉えたユーザーの眼の画像のみの分析で、外部カメラを使用せずに残りの顔表情を分類推測するのに十分であることを示します。

推測には、Deep learning(CNNベース)が用いられており、表現分類のため46人の被験者から訓練データを収集しました。

同時に、推測した顔の表情を動的アバターへリアルタイムに反映させることを可能にします。本アプローチは、すでに組み込まれているVRヘッドセット内視線追跡カメラを使用できることも特徴です。

関連

ザールラント大学ら、視線追跡において次見る場所を予測し低遅延で中心窩レンダリングする新提案を論文にて公開。モグラ叩きゲーム中のように高速に動くサッカード眼球運動に対応 | Seamless