カーネギーメロン大学の研究者は、自律エージェントに自然言語命令を与え、指定したタスクを実行させるためのタスク指向の言語接地のための訓練可能なエンドツーエンドアーキテクチャを提案した論文を発表しました。

Gated-Attention Architectures for Task-Oriented Language Grounding(PDF)

昨今、Amazon AlexaやGoogle Homeなどの人の言語を読み取り行動に移すデバイスは、音声制御技術の向上を示しましたが、まだまだ単純なコマンドしか扱っていないのが現状です。

自律型ロボットなどにおいては、人が発する自然言語命令を読み取り、目の前の環境からどれを指しているのか、どこにあるのか、などの概念理解を含めたより複雑なコマンドに対応する必要があります。

そこで、本論文では自然言語を自律エージェントにより理解させるため、強化学習と模擬学習のため、一人称視点ゲームに基づいた3D環境の中でシミュレーションするトレーニング手法を提案します。

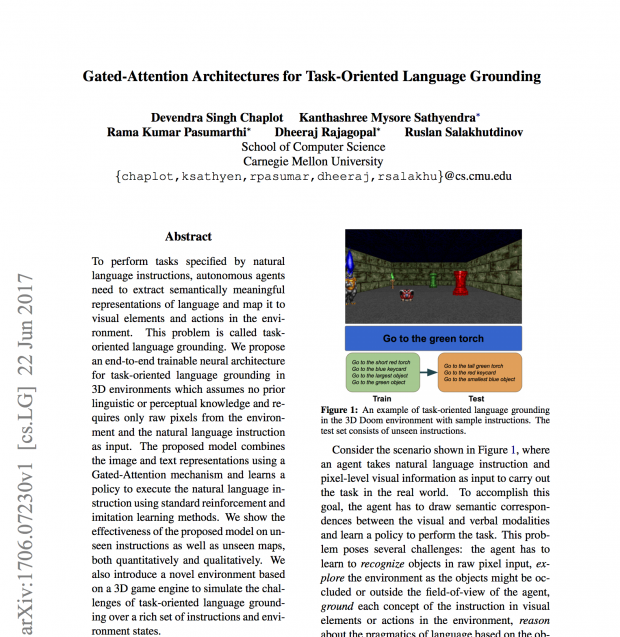

下のGIFのように、提示される周囲の環境と自然言語の指示だけで多様なオブジェクトの中から指定したオブジェクトへ向かうゲームを構築します。言語や知覚の知識は前提としてありません。

(テキストで指示が表示され、その通りマシンが動く様子)

(ゲームに登場するオブジェクトの種類)

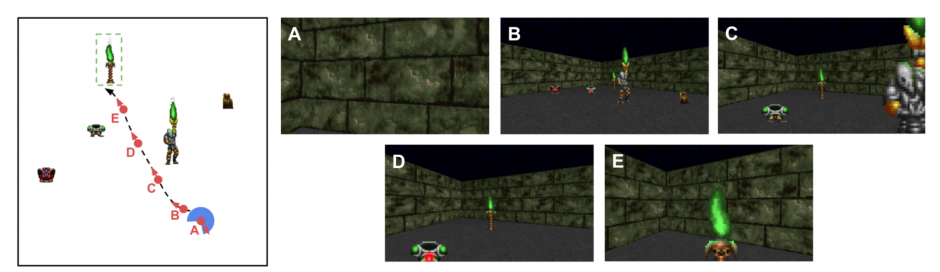

下の図のように行動を分解するとこうです。

青がエージェント、口が開いている方が視点、後ろの緑の炎が灯ったタイマツに向かうコマンドを指示します。

- A:まだ目的のオブジェクトが見えない。

- B:オブジェクトが視野に入るようにエージェントが回転。

- C:エージェントは緑の炎を持った銅像みたいなのを避ける。

- D:左の緑が入った鎧も回避。

- E:目標に到達。

といった具合に、一人称3Dゲーム環境で豊富な命令セットや環境状態に基づいてタスク指向の言語接地の課題をシミュレートし、エージェントが言語に関連付けてオブジェクトの色属性やサイズ属性などを認識することを学習します。

また、本モデルは3D環境で実行できることは現実世界でも実行できる重要なステップになる前提で行われています。

本論文を主導で執筆したDevendra Chaplot氏は、Linkedinによると現在AppleのインターンでAI研究をしているとのことです。

関連

ブラウン大学、ロボットに抽象的な指示を音声で出しても自然言語コマンド処理できるシステムを開発。抽象的な言語から所望のタスクを推定。人とロボットとのシームレスな対話への一歩 | Seamless